Preface

Learning Programming Book!

Python基础

Python是一种解释型、面向对象、动态数据类型的高级程序设计语言。

Python 本身也是由诸多其他语言发展而来的,这包括ABC、 Modula-3、 C、 C++、 Algol-68、 SmallTalk、 Unix shell 和其他的脚本语言等等。

环境配置

Python解释程序

运行Python程序

(1) 交互式编程

进入Python解释器环境,交互式执行命令语句。

$ python [options] # enter python environment

-q:进入交互式命令环境后,不输出提示信息。

安装pyreadline可以为终端启用tab命令自动补全功能。

(2) 脚本式编程

脚本是语句的集合,Python解释器会创建一个Python运行环境从而执行脚本中的语句。脚本执行完后,解释器退出运行环境。

python [options] -c "python_command" # 命令使用";"分隔

python [options] script.py [args] # execute python script

python [options] -m module_name [args] # 执行指定模块的内容(__main__)

当Python脚本首行指定了Python解释器路径,且该脚本具有可执行权限时,可直接运行该脚本。

#!/usr/bin/python # 指定执行该脚本的程序

#!/usr/bin/env python # 从路径中查找Python解释器以执行该脚本

python -m json.tool demo.json # 格式化JSON文本

python -m http.server 8080

python -m pydoc -p 8088 # python文档

python -m mimetypes filename

python -m tarfile -c demo.tar demo # tar

python -m gzip filename # => input only file, output filename.gz

python -m zipfile -c demo.zip demo

python -m telnetlib -d 192.168.56.200 22

运行环境

PYTHONPATH用于指定除系统的附加库搜索路径,程序启动后将加载到sys.path中。默认搜索顺序为当前路径、用户指定附加搜索路径、Python内置库路径、第三方Python库路径。PYTHONHOME指定Python标准库位置(prefix/lib/pythonversionandexec_prefix/lib/pythonversion);当PYTHONHOME为单个路径时,代替prefix和exec_prefix;反之,可以将PYTHONHOME设置为'prefix:exec_prefix'。PYTHONHOME==不是Python环境的安装目录==。PYTHONSTARTUP:启动Python Shell时需要执行的脚本路径。

如果使用虚拟环境,则通过激活命令(如

conda activate)可保证相关环境变量正确设置。

基本语法

标识符

所有标识符可以包括英文、数字以及下划线(_),但不能以数字开头,区分大小写。

以下划线开头的标识符是有特殊意义的。

- 以单下划线开头(

_foo)的代表不能直接访问的类属性,需通过类提供的接口进行访问,不能用from xxx import *而导入; - 以双下划线开头(

__foo)代表类的私有成员; - 以双下划线开头和结尾的(

__foo__)代表 Python 里特殊方法专用的标识,如__init__()代表类的构造函数。

运算符

数值运算符参看数值计算。

逻辑运算符

逻辑运算符用于控制流程中的条件语句,包括and 、or 、not。

Python不支持

&&,||。

成员运算符

in, not in:在指定的容器(序列、元组、字典、集合等)中查找到值,返回值True或False;==也可用于判断一个字符串是否为另一个字符串的子串。==

list_str = ['--test', '-o output/test', '--debug']

if '--debug' in list_str:

print('find --debug in parameter list.')

if 'test' not in list_str:

print('not find test in parameter list.')

取决于容器类型,查询时间复杂度不同。

身份运算符

is, is not:判断两个标识符是否引用同一个对象,返回True或False。 ==用于判断引用变量的==值==是否相等。

id()函数返回一个整数表示变量的标识;CPython实现的id(x)返回x的内存地址。

hash(obj)返回基于对象内容的一个映射值,具有相同值的两个对象有相同hash值(不同于消息摘要是基于字节序列内容的)。

对象运算符

+ 运算符用于拼接序列对象;

* 用于重复序列对象:如果对象的元素为值类型,则复制该元素的值并将复制内容拼接;如果元素为引用类型,则仅复制引用(浅拷贝)。

print str*2 # 输出字符串两次

[]:下标运算符,取字符串、列表或元组元素。

运算符优先级

语句

同一行显示多条语句,方法是用分号“ ;” 分开。但是我们可以使用斜杠( \)将一行的语句分为多行显示。语句中包含[],{}或() 括号就不需要使用多行连接符。

用缩进(空格)长度来写语句块。缩进的空白数量是可变的,但是所有代码块语句必须包含相同的缩进空白数量,这个必须严格执行。

eval可以执行字符串表示的Python表达式(不支持复杂的代码逻辑,例如赋值操作、循环语句),并返回表达式的值。

x = eval('os.path.abspath(os.path.curdir)')

exec执行语句或代码块,不能做表达式求值并返回,但可以通过赋值表达定义新的变量并添加到当前上下文中。

exec('x = os.path.abspath(os.path.curdir)')

https://www.cnblogs.com/pythonista/p/10590682.html。

注释和文档

单行注释:“#”

文件开始的注释内容提供解释器与脚本的相关信息。

#!/usr/bin/python

# -*- coding: UTF-8 -*-

脚本中包含中文时,需要指定文件的编码方式(UTF-8),默认编码方案是(ASCII)。Python3.X 源码文件默认使用utf-8编码,所以可以正常解析中文,无需指定 UTF-8 编码。

空行并不是Python语法的一部分。书写时不插入空行,Python解释器运行也不会出错。

位于类型定义之后的三引号文本(''',docstring)将自动生成为该类型的文档(type.__doc__)。

Package docstrings should be placed at the top of the package’s

__init__.pyfile. Module docstrings are placed at the top of the file even before any imports.

使用help()函数可查看当前环境已导入的模块的内容的文档。

文档生成

使用reStructuredText编写代码注释,可通过Sphinx自动转换为参考文档。

流程控制

条件

if expression1:

statements1……

elif expression2:

statements2……

else:

statements4……

c = a if <condition> else b

在Python中没有switch–case语句。

循环

while expression1:

statements……

else:

statements4……

for循环可以遍历任何序列的项目,例如字符串、列表;

for i = 1 to 10:

statements

for var in sequence: # 迭代过程不能更改迭代的对象

statements1(s)

break

continue

else:

statements2……

for idx,item in enumerate(lista): # enumerate构造(i, l(i))迭代元组

print('{idx} - {item}')

for idx,_ in enumerate(lista):

print('{idx} - {item}')

循环正常执行完之后,执行else语句。

sequence可以是索引集合:range(start,end, step=1)

pass语句

pass不做任何事情,一般用做占位语句。特殊变量...(Ellipse),可用于代替pass语句。

异常处理

触发异常

raise ExceptionObject, args, traceback

捕捉异常

try:

pass

except ExceptionName as e: # e为异常对象,如果不使用可省略as语句

statements1

except (Exception1, Exception2, ...) as e:

statements2

except:

statements3

else:

statements4

finally:

statementsN

Python 2.x语法:

try: statements except ExceptionType, Argument: statements

异常处理方法

处理异常时可使用traceback获取调用栈的信息。打印堆栈追踪信息:

traceback.print_exc() # 打印stacktrace

traceback.format_exc() # 返回stacktrace为字符串

traceback.print_tb(err.__traceback__) # stacktrace

对于捕获到的异常,如果没有合适处理方法可再次抛出异常。

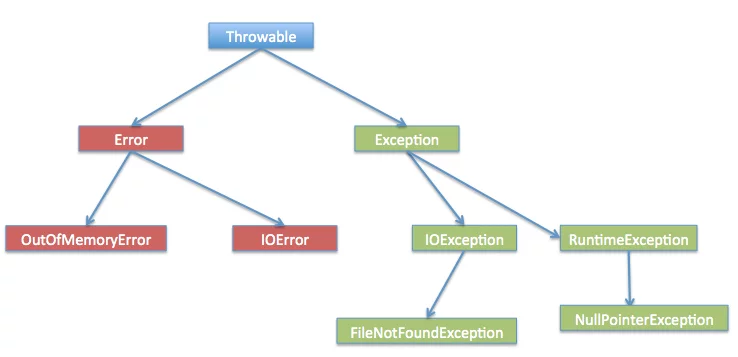

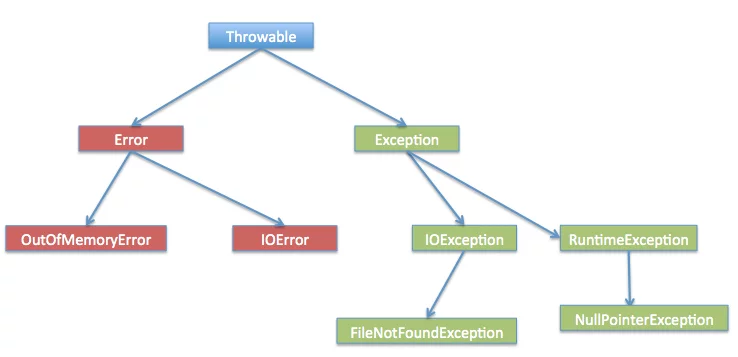

异常类型

所有异常基于BaseException。Exception类用于定义用户异常。Warning也继承自Exception类,但通常不用于触发异常,而是用于产生警告信息。

Exception hierarchy:https://docs.python.org/3/library/exceptions.html#os-exceptions

内置异常类型:

ArithmeticError

BufferError

LookupError: IndexError, KeyError

AssertionError

EOFError

GeneratorExit

ImportError

ModuleNotFoundError

KeyboardInterrupt

MemoryError

NameError, TypeError, UnboundLocalError, ValueError, IOError, WindowsError

NotImplementedError

SystemError, SystemExit, EnvironmentError

OSError

https://docs.python.org/3/library/exceptions.html#os-exceptions

OverflowError, ZeroDivisionError

RecursionError

ReferenceError

RuntimeError

StopIteration, StopAsyncIteration

SyntaxError, IndentationError, TabError

UnicodeError, UnicodeEncodeError, UnicodeDecodeError, UnicodeTranslateError

with-as (Context Manager)

上下文管理协议:实现方法是为一个类定义__enter__和__exit__两个函数。

with open_resource(args) [as target(s)]:

do_something

with-as语句的执行过程是,首先执行__enter__函数,它的返回值会赋给as后面的变量。

然后开始执行with-block中的语句,在with-block执行完成或发生异常或退出,会执行__exit__函数(释放资源或处理可能产生的异常)。

支持上下文管理协议的类

class Resource():

def __enter__(self): # 实际分配资源的操作在该方法中,而不在__init__()中

print('===connect to resource===')

return self

def __exit__(self, exc_type, exc_val, exc_tb):

print('===close resource connection===')

return True

contextlib.contextmanager装饰器

使用该装饰器可将构造资源的函数转换为支持上下文管理协议。

import contextlib

@contextlib.contextmanager

def open_func(file_name):

# __enter__ method

file_handler = open(file_name, 'r')

try:

yield file_handler

# __exit__ method

except Exception as exc: # 如果不需处理异常则无需使用try-except语句

pass

finally:

file_handler.close()

Exit handlers

atexit模块用于注册程序==正常退出==前的清理函数。可以注册多个函数,函数执行顺序与注册顺序相反。

atexit.register(func, *args, **kwargs)

atexit.unregister(func)

如果子进程由os.fork()创建,则继承父进程的退出处理函数;如果子进程由multiprocessing模块创建,则不会继承退出处理函数。

When used with C-API subinterpreters, registered functions are local to the interpreter they were registered in.

函数

定义函数

def function_name(arg1: int, arg2: float) -> float

"documentation"

statements

[return expr1, expr2, ...]

函数内部可访问全局脚本语句定义的变量。可以为输入输出参数添加类型提示。

参数

参数传递:不可变类型(数值、字符串、元组等)是值传递,可变类型(列表、字典、集合等)是引用传递;

关键字参数:使得调用函数时传入参数顺序可以与定义时不同,也可以为参数设置默认值(默认值在模块初始化时构造);关键字参数必须置于所有位置参数之后。

def func(arg1, age=50, name="miki")

不定长参数

*args用于传递任意数量的位置参数(列表或元组),**kwargs用于传递任意数量的关键字参数(字典)。

def functionname(formal_args, *args,**kwargs)

在函数调用时,也可以使用

*args将参数列表传递到函数中(需要与函数声明的参数个数或*args声明匹配),使用**kwargs将字典传入函数作为关键字参数(将值赋给与键名相同的参数,或与**kwargs声明匹配)。

返回值

通过return语句可以设置一个或多个返回值,或不返回值。

return不用于脚本退出,使用sys.exit()退出。

当返回多个值时,如果仅提供一个输出参数,则将返回值构造成元组。若提供多个参数存储返回值,则将从元组中一次读取元素给输出参数。

a, b, c = function_name(...) # 等效于 (a,b,c) = func_name(...)

d = function_name(...) # d = (a,b,c)

匿名函数 (Lambda表达式)

将函数作为对象保存和引用,也可以在使用函数的地方直接定义(而非使用def定义普通函数)。

add = lambda x, y : x+y

f = lambda x: 1 if x > 0 else -1

the_sum = add(1,2)

变量

Python的主要内置类型有数值、序列(string、list和tuple)、映射、类、实例和异常,方法也可以看作特殊的对象类型。每个变量(object)具有一个标识、类型和值。

创建和删除变量

定义变量不需要声明类型,根据赋值的类型确定变量类型。

a = b = c = 1

a, b, c = 1, 2, "john"

变量可重复赋值,赋值前后类型不需要一致(由赋值类型决定)。

删除变量:

del var_a, var_b

del list[i], dict[name]

变量作用域

在文件范围中定义的变量具有文件作用域,在文件其后的任意位置(包括调用的函数内部)都能访问。各文件中定义的变量属于不同的命名空间(模块名),互不影响。要引用其他模块中定义的全局变量,可使用import语句引入其他模块通过模块名访问或直接将该变量引入当前文件的命名空间。

import module

print(module.global_var)

from module import global_var

在文件中定义的函数引用全局变量时,总是引用该文件作用域中的全局变量,而不会使用调用该函数的文件中的全局变量。

可见性

当函数内部定义了与全局变量同名的局部变量,则全局变量将被隐藏(即使在定义局部变量之前也不能引用该同名全局变量)。使用global用于在函数内部对全部变量的声明和修改。

a = 'initialized'

def func()

global a

a = 'modified'

获取作用域中的变量信息:

dict_vars = locals() # 获取当前的局部作用域中的变量

dict_vars = globals() # 获取全局作用域中的变量

包括变量、函数、模块等信息。

在流程控制语句块中定义的变量在离开语句块后仍有效。

类型信息判断

type()返回变量的==类型信息可以和类型对象进行比较==。

type_info = type(var_name)

tf = type(x) == int # return True if x is int.

get_type_hints()可以查看模块、类、方法或函数的类型信息。

from typing import get_type_hints

Vector = list[float] # type alias

from typing import NewType

UserId = NewType('UserId', int) # New simple type

isinstance判断实例是否为某个类型(父类)的实例:

isinstance(obj, Type)

isinstance(obj, (Type1, Type2, ...)) # 任意一种类型

Type是在程序中使用的变量类型,不是字符串,例如pd.DataFrame,np.ndarray。

issubclass判断一种类型是否为某类型的子类:

isdubclass(subType, Type)

类型提示

age: int = 1 # 可不提供初始化值

容器类型需要使用专门定义的类型修饰变量。

from typing import List, Set, Dict, Tuple, Optional, Callable

x: Set[int] = {6, 7}

x: Dict[str, float] = {'field': 2.0}

x: Tuple[int, str, float] = (3, "yes", 7.5) # fixed size tuple

x: Tuple[int, ...] = (1, 2, 3) # variable size tuple

x: Optional[str] = some_function() # values that could be None

x: Callable[[int, float], float] = f # function

类型别名:

vector = List[float]

迭代器提示。

参数提示仅作为编写程序的辅助工具,在程序运行时并不会做相应的类型检查。

联合类型

可以为参数指定类型,且可使用typing.Union指定多种类型;

from typing import Union

def function_name(arg1:Union[str,int])

常量类型

from typing import Final # [Python 3.8]

Type hints cheat sheet (Python 3)。

类

类的定义:由成员,方法,数据属性组成。

class ClassName:

'''documentation''' #类文档字符串

static_var: Type = value

var1: Type # Annotate a member does not make it static.

# 构造函数

def __init__(self, value1, value2, ...) -> None:

self.var1 = value1 # 成员变量

self.var2 = value2

...

# 析构函数

def __del__(self):

release_unmanaged_resources

# 成员方法

def method_name(self, arg1, arg2, ...):

self.xxx # 调用类的成员变量或方法

# statements...

@staticmethod # 静态方法

def method_name(...)

statements

@property # read only property

def prop(self):

return self.xxx

@x.setter

def x(self, value):

self.__x = value

@x.deleter

def x(self):

del self.__x

静态变量

静态成员变量仅能通过类名或静态方法访问。实例可以定义与静态成员同名的成员变量(通过实例引用将隐藏静态变量)。子类可以定义与父类同名的静态变量(隐藏),通过子类名或实例将只能访问子类的静态变量。

==对实例成员的类型注释由于没有初始化,因此不会被视为静态变量==。

静态变量初始化:可在类外部对静态变量进行初始化,从而基于父类的静态变量对子类静态变量进行初始化。在子类内部使用父类静态变量初始化子类静态变量无效(得到None)。

构造

浅拷贝:很多类型(例如list、dict)提供copy()方法,支持对象的浅拷贝。这意味着对象中的成员变量如果是引用类型,则两个对象共享该引用类型成员。

析构函数__del__ ,__del__在对象销毁的时候被调用,当对象不再被使用时,__del__方法运行。Python使用了引用计数这一简单技术来跟踪和回收垃圾。

obj = ClassName(args) # 创建对象

使用.运算符来访问对象的属性。

类的成员

类可以看作由元数据、用户定义数据和方法组成的字典,使用dir(x)(x.__dir__())返回类包含的属性和方法组成的字典。

类的方法与普通的函数只有一个特别的区别——它们必须有一个额外的第一个参数名称, 按照惯例它的名称是 self(self不是Python关键字,换成其他标识符仍然有效)。self代表的是类的实例,代表当前对象的地址,而self.__class__是类的类型信息。

Python成员不存在访问控制,仅通过标识符在语义上区分。

-

__<private_member>:标记为私有属性/方法,其中形如__INNER_MEMBER__的成员为类的元数据。 -

_<protected_member>:标记为保护属性/方法。 -

<public_member>:标记为公开属性/方法。

类的元数据

通过类或对象均可访问类的元数据(所有对象共享)。

__class__:类型元信息(即type类型对象,等效于type(obj));

__name__:类名(字符串,==不包含类所在的包名==)。

__bases__ : 类的所有父类元信息构成的元素(包含了一个由所有父类组成的元组) 。

__dict__:所有成员变量名与对应的值组成的字典,等效于vars(obj);

__doc__:类的文档字符串 。

__module__: 类定义所在的模块(类的全名是__main__.className,如果类位于一个导入模块mymod中,那么className.__module__等于 mymod)

实例的元数据

obj.__str__(),:类成员信息的字符串表示,自动转换为字符串类型时调用该方法;

obj.__repr__():返回构造该对象的语句,repr(obj)会调用对象的该方法。调用eval(repr(obj))可重新构造该对象。

描述符协议

在类里实现了 __get__() 、__set__()、__delete__()其中至少一个方法。

class Score:

def __init__(self, default=0):

self._score = default

def __set__(self, instance, value): # 设置属性的值,进行验证

if not isinstance(value, int):

raise TypeError('Score must be integer')

if not 0 <= value <= 100:

raise ValueError('Valid value must be in [0, 100]')

self._score = value

def __get__(self, instance, owner): # 属性不存在、不合法等都可以抛出对应的异常

return self._score

def __delete__(self): # 删除内容

del self._score

class Student:

def __init__(math_score):

self.math = Score(math_score)

pass

数据类

dataclass(Python 3.7+)专门用于定义和存储数据的类型(更加适合序列化),封装了数据的初始化方法和基本运算方法(避免频繁编写这些基础代码)。dataclass继承自object类型,因此,开发者仍可基于dataclass编写自定义方法1。

定义数据

基于类型提示语法自动生成对应成员的定义,而无需重复在初始化方法中声明和初始化成员。

from dataclasses import dataclass

@dataclass

class Persion:

first_name: str

last_name: str = "Wang" # 支持默认值, 但必须在所有非默认值参数后

age: int

job: str

full_name: str = field(init=False, repr=False) # *

dataclass会自动生成__init__()、__eq__()(自动对比对象的所有成员)和__expr__()方法。由于dataclass的构造方法是自动生成的,也因此无法向父类传递初始化参数,所以通常自定义dataclass类型不再继承其他类。

*:当该成员的初始化依赖于其他成员变量时,不在自动生成的构造函数中初始化,而是在__post_init__方法中定义初始化方法。这种方式避免使用属性,在每次调用时需要重复计算值。

非可变对象

声明@dataclass(frozen=True),对象初始化后无法被更改。

数据转换

可轻易转换为元组或字典。

from dataclass import astuple,asdict

person:Tuple = astuple(Person(...))

person:Dict = asdict(Persion(...))

比较接口

@dataclass(order=True)将自动生成__lt__、__le__、__gt__、__ge__方法,从而支持排序比较。默认将对类中所有字段以此进行比较,在类定义中添加特殊的sort_index字段,该字段引用其他成员变量的值以定义排序参考值。

@dataclass(order=True)

class Persion:

# ...

sort_index: int = field(init=False, repr=False)

def __post_init__(self):

self.sort_index = self.age

继承语法

class ClassName (ParentClass1[, ParentClass2, ...]): # 支持多重继承

'Optional class documentation string'

def __init__(self, args):

super().__init__(...) # <=> super(ClassName, self).__init__(args)

# ...

在继承中基类的构造(__init__()方法)不会被自动调用,它需要在其派生类的构造中手动。需要通过基类名调用__init_()并且传递self变量。

方法重写(override)

当方法被重写后,==通过对象调用方法时将调用子类的方法==(即使是在父类中)。要通过super()以显式调用父类方法。

super().method(args) # <=> super(ClassName, self).method(args)

同名函数或成员调用:使用super().member()调用MRO搜索顺序上第一个存在该成员的类。如果要显式调用某一父类的方法,则使用super(SuperClass, self).method(args)。

在基于

pdb的调试环境下,如果在调试窗口调用父类方法,使用super().method(args)会报错(程序中正常执行)。

运算符重载

MRO(Method Resolution Order)

父类的初始化顺序:根据继承关系“深度优先—从左至右”搜索父类,确定初始化顺序(调用classname.__mro__查看类的搜索顺序)。

- 深度优先,按继承关系依次调用父类构造函数;

- 从左至右,当深度搜索到达顶端后,==如果顶层父类包含

super().__init__()调用==,则将调用第二条继承关系上的类型,并执行深度优先初始化; - 如果两条继承路线存在公共父类,则在第一条继承路线搜索到公共父类前会跳转到第二条继承路线,由第二条继承路线搜索到公共父类;多条继承路线具有公共父类的情况同理。

- 如果搜索过程中,某父类不存在

super().__init__(),则从该父类的代码开始,并按调用栈反向执行初始化。==在构造过程中已经被前面构造函数初始化过的属性会被后调用的构造方法再次初始化==。

如果在MRO搜索顺序中某个直接或间接父类未调用

super().__init__(),则==MRO初始化过程中断==(该类及MRO搜索顺序的后续类的构造方法不会被调用)。

参数传递:

-

==初始化过程中的参数传递与初始化顺序一致,而非子类分别传递给其各个直接父类==。因此在声明父类时,一定要将能通过

super().__init__()传递参数的父类声明在前,否则其后的父类无法获取参数。 -

传递给父类参数通常使用

*args和**kwargs代替(除非子类需要对相关参数进行处理)。def __init__(self, a,b,*args,c=1,b='hello',**kwargs)位置参数的顺序保持子类参数在前,父类参数在后(从而可以使用

*args来统一接收父类参数)。

Python Multiple Inheritance - JournalDev

mixin

抽取单一功能,提供给多个类继承,可视为带实现的接口;mixin模式适用于多个类各自有继承主线,但又共享部分功能。这部分功能即可通过mixin类型实现。

mixin类型不定义新的成员变量,仅定义关于目标混入对象的计算方法(可使用期望继承的类所包含的成员)。

https://stackoverflow.com/q/533631/6571140。

迭代器

迭代器Iterator提供__next__()方法以遍历所有元素;使用yield关键字的方法也可以实现简单迭代器。

def g(n: int) -> Iterator[int]:

i = 0

while i < n:

yield i

i += 1

可迭代对象Iterable提供两个方法:__iter__()和next()。通过iter(Iterable)可获取访问可迭代对象的迭代器。for语句实际需要传递迭代器对象,通过语法糖简化了对可迭代对象的访问语法。

python - What exactly are iterator, iterable, and iteration? - Stack Overflow

内存占用

import sys

s = sys.getsizeof(var)

所有内置类型均以对象封装,因此返回的为对象占用的内存(仅计算对象本身占用的内存,而不包括对象引用的内存)。第三方类型类型返回结果不一定准确。

程序结构

程序入口

模块中非类、函数定义的代码部分将在引用时被执行。

通过以下方式为程序设置一个入口,从而屏蔽引用模块中的非定义代码:

if __name__ == '__main__':

main_procedure

else:

module_initialization

注意:上述代码并非常规的主函数(

main(args)),只是一个普通的条件语句。可以自定义一个常规的主函数在上述结构中进行调用。

def main(args=None):

if args is None:

args = sys.argv

# main code

return value

if __name__ == '__main__':

sys.exit(main(sys.argv[1:]))

命令行参数处理

sys.argv[0]表示程序名,其他元素为传入参数。

for argi in sys.argv:

print(argi)

getopt

getopt采用Linux Shell的参数声明规则设置参数。读取参数的方法:

与UNIX类系统不同,非选项参数后的所有参数都不会被视为选项解析。

from getopt import getopt, GetoptError

options, args = getopt(cmd_args, short_opts, long_opts=[])

short_opts:代表短选项(命令行以-开头)的字母列表,如果一个选项还对应一个值,那么字母后添加:;

long_opts:代表长选项(命令行以--开头)的字符串列表,长选项如果需要一个值,则参数需要附加=。

命令行中,长选项的值可作为一个当都参数,或使用

=附加在选项名后。

返回值:options为选项列表,包括选项名(包括前缀)和对应的值(没有值则为空字符串);args为非选项参数。

典型用法:

def usage():

# print usage of the program, including options.

def main(sys_args):

try:

optlist, args = getopt(sys_args, short_opts, long_opts=[])

except GetoptError as err:

print(err) # will print something like "option -a not recognized"

usage()

return(2)

for option, value in optlist:

if option == '--test' or option == '-t':

# do something

...

ArgumentParser

ArgumentParser替代了OptionParser(从Python 3.2)。

创建参数转换实例:

from argparse import ArgumentParser

parser = ArgumentParser(

prog=None, # program name (default: sys.argv[0])

description=None, # information before argument help

usage=None, # usage syntax (default: auto generate)

epilog=None, # information after argument help

parent=[parent_parsers] # 继承父解析器实例的解析方法

)

parent:指定继承的参数解析实例。

添加参数规则:

parser.add_argument(

names_or_flags, # 可变参数列表:'--test', '-t', 'argname'

required=False,

dest='optname', # attribute name in return options

action='store',

nargs=1, # number of option arguments

const=0, #

default=None, # default value if not specified from command line

type=str, # type of option arguments

help=None, # option's usage information

metavar='NAME' # 帮助信息中作为选项值的标识(默认为长选项名大写)

)

ArgumentParser对参数控制更加严格,如果出现未配置的参数将产生异常。==参数名如果没有前缀,则代表位置参数==;而OptionParser将位置参数存储到一个单独的返回参数中。

参数解析规则说明:

dest:解析参数列表后存储参数值的变量名(参看parse_args()方法);如果没有指定字段,则会根据选项名生成合法的字段名;

nargs=N:选项所需要的参数个数,消耗N个参数构成列表。当需要获取位置参数而非选项时,nargs='?'消耗一个位置参数,nargs='*'消耗所有位置参数构成列表,此时names_or_flags作为存储位置参数的变量名。

type:值的类型,包括:string(默认)、int、float;整数值可以和短选项名组成一个参数,例如-n42等价于-n 42;bool类型参数使用store_true, store_false;

action:检测到选项后的处理方式

store:(默认处理方式)储存值,值的类型通过type指定;store_true|store_false:储存bool值True/False,对应的选项不需要另外参数设置值;store_const:'store_const'和'append_const'与const关键字结合使用,用于为选项保存一个常量。

default:选项的默认值(选项未出现在命令行的情况下设置默认值)。选项如果不是

bool类型,在命令行使用选项时必须提供值;

help:选项的帮助信息。当解析参数时,遇到-h或--help(程序退出)或调用parser.print_help()时会自动输出所有帮助信息。

%default可用于在帮助信息中表示输出变量的默认值。ArgumentParser自带-h,--help选项,命令行提供该选项时将输出帮助信息。参数解析器默认会添加帮助选项(

-h,--help),如果要禁用,设置parser.add_help=False。

转换命令行参数(默认为sys.argv[1:],==注意传入给args不要展开==):

options = parser.parse_args(args=None, namespace=None)

未在命令行提供的选项也会出现在options中,其值为默认值。返回值为NameSpace类型。

click

如果命令行嵌套子命令,可使用click进行命令转发。

程序运行信息

from inspect import currentframe, getframeinfo

frameinfo = getframeinfo(currentframe())

frameinfo.filename # 当前运行代码所在文件

frameinfo.lineno # 当前运行代码所在行号

frameinfo.function # 当前运行代码所在函数

模块(Module)

模块是一个文件,其中包含类,函数等的定义。==模块相当于一个命名空间,其中的定义与其他模块隔离==。

导入模块

import mod # modulename <- sys.modules['mod']

import mod as alias # aliasname <- sys.modules['mod']

from mod import name # objname <- sys.modules['mod'].name

from module import (name1,name2,...,namen,)

from module import * # 导入所有内容

from mod import name as alias # aliasname <- sys.modules['mod'].name

import importlib

path = importlib.import_module("os.path") # => import os.path as path

file, pathname, desc = importlib.find_module('os') # 查找模块

不能直接导入模块中的内容并设置别名。

从模块所在目录导入其他模块:

from . import module_name

相对路径是根据导入声明的包名

package.subpackage.module确定的,因此不可使用相对导入声明路径范围外的模块。由于__main__模块不包含任何路径信息,因此无法使用相对导入。

5. The import system — Python 3.9.5 documentation

引用模块

当导入整个模块时,使用模块名称访问其中的内容(类、函数等);也可以直接导入模块中的特定内容。

{module|alias}.name # use module contents via module name/alias

name # use name/alias to refer an imported class,funcion,...

alias

重载模块

检查模块是否导入:sys.modules记录了运行环境已导入的模块,从而防止模块被重复导入。

tf = 'modulename' in sys.modules # dict

tf = 'importedname' in dir() # 当前可见名称

tf = 'importedname' in globals() # 全局变量

重新加载修改过的包到当前正在运行的程序:

import importlib

importlib.reload(module) # <class module> not str

查看模块的文档

help(len) # doc for built-in functions

import pandas as pd

help(pd) # module doc

help(pd.DataFrame) # class doc

help(pd.DataFrame.to_csv)# function doc

相互引用

注意引用对象顺序,避免先引用未初始化的对象。

# in module A

from module B import b

def a()

# in module B

from module A import a

包(Package)

Package是特殊的模块(包含__path__属性的模块),包含subpackage和module。

常规package通常是一个文件夹中的所有模块以及子文件夹(sub-package)组成。__init__.py文件用于标识目录是一个package。当包被导入时,会自动执行__init__.py文件

my_package/

├── __init__.py

├── subpackage1/

│ ├── __init__.py

│ ├── module_x.py

│ └── module_y.py

├── subpackage2/

│ ├── __init__.py

│ └── module_z.py

└── module_a.py

Namespace packages

A namespace package is a composite of various portions, where each portion contributes a subpackage to the parent package. Portions may reside in different locations on the file system.

导入包中的模块

导入包名(相对搜索路径的目录路径)后,通过包名访问其中的内容;或将包名作为前缀导入其中的模块。

import pkg

import pkg.mod # packagename <- sys.modules['pkg']

import pkg.mod as alias # aliasname <- sys.modules['pkg.mod']

from pkg import mod # modulename <- sys.modules['pkg.mod']

from pkg import mod as alias # aliasname <- sys.modules['pkg.mod']

导入包名的时候会执行包目录下的__init__.py加载包中的模块。没有在__init__.py中指定加载的模块需要手动加载(import pkg.mod)。

查找路径

sys.path 是一个保存了查找包的路径的列表。Python解释器会自动将==Python程序所在目录==加入路径,从而方便导入同一目录下的其他文件。

==不要在包内部编写测试脚本==,运行该测试脚本时会将该脚本所在路径加入查找路径,从而破坏其所在包的结构。

程序的工作目录(

path.abspath(os.curdir))与程序所在目录可能不同,且不会加入搜索路径。语法检查的查找路径:在进行语法检查时(例如在VS Code中使用

pylint检查器),检查器的会将当前工作目录加入搜索路径,因此跟程序运行时的情形不同。为了保证程序运行时的路径也在检查器中,可在项目配置文件(settings.json)中配置"python.analysis.extraPaths": ["E:/Workspace/python"]

可以添加自定义搜索路径以导入第三方包:

sys.path.insert(0, '/lib/path') # 添加至头部

sys.path.append('/lib/path') # 添加至尾部

查询包是否在本地可加载:

import importlib

spec = importlib.util.find_spec("dask.dataframe") # None if not find

相对导入

from . import module # 导入同一包内同一层级的子包(或模块)

from .. import module # 导入同一包内上一层级的子包(或模块)

from .package import module

from ..package import module

不要将子包所在路径加入搜索路径,否则不能识别完整包结构,导致相对导入失败。

Python Modules and Packages – An Introduction。

标准库和应用

日期和时间

CGI

密码学

消息摘要

Python内置hashlib(消息摘要算法),包括 FIPS 的 SHA1, SHA224, SHA256, SHA384, and SHA512 (定义于 FIPS 180-2) 算法,以及 RSA 的 MD5 算法( 定义于 Internet RFC 1321)。消息摘要算法的输入为字节序列

在

zlib模块中包括adler32 或 crc32 哈希函数。

import hashlib

m = hashlib.sha256(b'init_data')

# m.update(a); m.update(b) => m.update(a+b)

m.update(b"Nobody inspects") # 向该对象追加消息(字节序列)

m.update(b" the spammish repetition")

m.digest() # 或hexdigest()

为了防止黑客通过彩虹表根据哈希值反推原始口令,在计算哈希的时候,不能仅针对原始输入计算,需要增加一个salt来使得相同的输入也能得到不同的哈希,这样,大大增加了黑客破解的难度。

加密算法

cryptography包含加密、消息摘要以及密钥生成等方法。

The low-level cryptographic primitives are often dangerous and can be used incorrectly. They require making decisions and having an in-depth knowledge of the cryptographic concepts at work.

PyCryptodome (代替pycrypto):Python Cryptography Toolkit提供加密算法(AES, DES, RSA, ElGamal, ...),同时也提供安全哈希函数(SHA256,MD5等)。

from Crypto.Hash import SHA256

hash = SHA256.new() # update, digest, hexdigest

from Crypto.Cipher import AES

obj = AES.new('This is a key123', AES.MODE_CBC, 'This is an IV456')

message = "The answer is no"

ciphertext = obj.encrypt(message)

obj2 = AES.new('This is a key123', AES.MODE_CBC, 'This is an IV456')

obj2.decrypt(ciphertext)

from Crypto.PublicKey import RSA

from Crypto import Random

random_generator = Random.new().read

key = RSA.generate(1024, random_generator)

signature = key.sign(hash, '')

public_key=key.publickey()

public_key.verify(hash_ver,signature)

cryptography vs PyCrypto | LibHunt

HMAC

hmac — Keyed-Hashing for Message Authentication — Python 3.10.7 documentation

RFC 2104 - HMAC: Keyed-Hashing for Message Authentication (ietf.org):通信双方使用共享密钥对消息的摘要(如MD5、SHA-1等)进行完整性进行校验。

import hmac

h = hmac.new(key, message, digestmod='MD5')

常见问题

-

ModuleNotFoundError: No module named 'win32api'

安装

pypiwin32包。

参考文献

Python基础

Python是一种解释型、面向对象、动态数据类型的高级程序设计语言。

Python 本身也是由诸多其他语言发展而来的,这包括ABC、 Modula-3、 C、 C++、 Algol-68、 SmallTalk、 Unix shell 和其他的脚本语言等等。

环境配置

Python解释程序

运行Python程序

(1) 交互式编程

进入Python解释器环境,交互式执行命令语句。

$ python [options] # enter python environment

-q:进入交互式命令环境后,不输出提示信息。

安装pyreadline可以为终端启用tab命令自动补全功能。

(2) 脚本式编程

脚本是语句的集合,Python解释器会创建一个Python运行环境从而执行脚本中的语句。脚本执行完后,解释器退出运行环境。

python [options] -c "python_command" # 命令使用";"分隔

python [options] script.py [args] # execute python script

python [options] -m module_name [args] # 执行指定模块的内容(__main__)

当Python脚本首行指定了Python解释器路径,且该脚本具有可执行权限时,可直接运行该脚本。

#!/usr/bin/python # 指定执行该脚本的程序

#!/usr/bin/env python # 从路径中查找Python解释器以执行该脚本

python -m json.tool demo.json # 格式化JSON文本

python -m http.server 8080

python -m pydoc -p 8088 # python文档

python -m mimetypes filename

python -m tarfile -c demo.tar demo # tar

python -m gzip filename # => input only file, output filename.gz

python -m zipfile -c demo.zip demo

python -m telnetlib -d 192.168.56.200 22

运行环境

PYTHONPATH用于指定除系统的附加库搜索路径,程序启动后将加载到sys.path中。默认搜索顺序为当前路径、用户指定附加搜索路径、Python内置库路径、第三方Python库路径。PYTHONHOME指定Python标准库位置(prefix/lib/pythonversionandexec_prefix/lib/pythonversion);当PYTHONHOME为单个路径时,代替prefix和exec_prefix;反之,可以将PYTHONHOME设置为'prefix:exec_prefix'。PYTHONHOME==不是Python环境的安装目录==。PYTHONSTARTUP:启动Python Shell时需要执行的脚本路径。

如果使用虚拟环境,则通过激活命令(如

conda activate)可保证相关环境变量正确设置。

基本语法

标识符

所有标识符可以包括英文、数字以及下划线(_),但不能以数字开头,区分大小写。

以下划线开头的标识符是有特殊意义的。

- 以单下划线开头(

_foo)的代表不能直接访问的类属性,需通过类提供的接口进行访问,不能用from xxx import *而导入; - 以双下划线开头(

__foo)代表类的私有成员; - 以双下划线开头和结尾的(

__foo__)代表 Python 里特殊方法专用的标识,如__init__()代表类的构造函数。

运算符

数值运算符参看数值计算。

逻辑运算符

逻辑运算符用于控制流程中的条件语句,包括and 、or 、not。

Python不支持

&&,||。

成员运算符

in, not in:在指定的容器(序列、元组、字典、集合等)中查找到值,返回值True或False;==也可用于判断一个字符串是否为另一个字符串的子串。==

list_str = ['--test', '-o output/test', '--debug']

if '--debug' in list_str:

print('find --debug in parameter list.')

if 'test' not in list_str:

print('not find test in parameter list.')

取决于容器类型,查询时间复杂度不同。

身份运算符

is, is not:判断两个标识符是否引用同一个对象,返回True或False。 ==用于判断引用变量的==值==是否相等。

id()函数返回一个整数表示变量的标识;CPython实现的id(x)返回x的内存地址。

hash(obj)返回基于对象内容的一个映射值,具有相同值的两个对象有相同hash值(不同于消息摘要是基于字节序列内容的)。

对象运算符

+ 运算符用于拼接序列对象;

* 用于重复序列对象:如果对象的元素为值类型,则复制该元素的值并将复制内容拼接;如果元素为引用类型,则仅复制引用(浅拷贝)。

print str*2 # 输出字符串两次

[]:下标运算符,取字符串、列表或元组元素。

运算符优先级

语句

同一行显示多条语句,方法是用分号“ ;” 分开。但是我们可以使用斜杠( \)将一行的语句分为多行显示。语句中包含[],{}或() 括号就不需要使用多行连接符。

用缩进(空格)长度来写语句块。缩进的空白数量是可变的,但是所有代码块语句必须包含相同的缩进空白数量,这个必须严格执行。

eval可以执行字符串表示的Python表达式(不支持复杂的代码逻辑,例如赋值操作、循环语句),并返回表达式的值。

x = eval('os.path.abspath(os.path.curdir)')

exec执行语句或代码块,不能做表达式求值并返回,但可以通过赋值表达定义新的变量并添加到当前上下文中。

exec('x = os.path.abspath(os.path.curdir)')

https://www.cnblogs.com/pythonista/p/10590682.html。

注释和文档

单行注释:“#”

文件开始的注释内容提供解释器与脚本的相关信息。

#!/usr/bin/python

# -*- coding: UTF-8 -*-

脚本中包含中文时,需要指定文件的编码方式(UTF-8),默认编码方案是(ASCII)。Python3.X 源码文件默认使用utf-8编码,所以可以正常解析中文,无需指定 UTF-8 编码。

空行并不是Python语法的一部分。书写时不插入空行,Python解释器运行也不会出错。

位于类型定义之后的三引号文本(''',docstring)将自动生成为该类型的文档(type.__doc__)。

Package docstrings should be placed at the top of the package’s

__init__.pyfile. Module docstrings are placed at the top of the file even before any imports.

使用help()函数可查看当前环境已导入的模块的内容的文档。

文档生成

使用reStructuredText编写代码注释,可通过Sphinx自动转换为参考文档。

流程控制

条件

if expression1:

statements1……

elif expression2:

statements2……

else:

statements4……

c = a if <condition> else b

在Python中没有switch–case语句。

循环

while expression1:

statements……

else:

statements4……

for循环可以遍历任何序列的项目,例如字符串、列表;

for i = 1 to 10:

statements

for var in sequence: # 迭代过程不能更改迭代的对象

statements1(s)

break

continue

else:

statements2……

for idx,item in enumerate(lista): # enumerate构造(i, l(i))迭代元组

print('{idx} - {item}')

for idx,_ in enumerate(lista):

print('{idx} - {item}')

循环正常执行完之后,执行else语句。

sequence可以是索引集合:range(start,end, step=1)

pass语句

pass不做任何事情,一般用做占位语句。特殊变量...(Ellipse),可用于代替pass语句。

异常处理

触发异常

raise ExceptionObject, args, traceback

捕捉异常

try:

pass

except ExceptionName as e: # e为异常对象,如果不使用可省略as语句

statements1

except (Exception1, Exception2, ...) as e:

statements2

except:

statements3

else:

statements4

finally:

statementsN

Python 2.x语法:

try: statements except ExceptionType, Argument: statements

异常处理方法

处理异常时可使用traceback获取调用栈的信息。打印堆栈追踪信息:

traceback.print_exc() # 打印stacktrace

traceback.format_exc() # 返回stacktrace为字符串

traceback.print_tb(err.__traceback__) # stacktrace

对于捕获到的异常,如果没有合适处理方法可再次抛出异常。

异常类型

所有异常基于BaseException。Exception类用于定义用户异常。Warning也继承自Exception类,但通常不用于触发异常,而是用于产生警告信息。

Exception hierarchy:https://docs.python.org/3/library/exceptions.html#os-exceptions

内置异常类型:

ArithmeticError

BufferError

LookupError: IndexError, KeyError

AssertionError

EOFError

GeneratorExit

ImportError

ModuleNotFoundError

KeyboardInterrupt

MemoryError

NameError, TypeError, UnboundLocalError, ValueError, IOError, WindowsError

NotImplementedError

SystemError, SystemExit, EnvironmentError

OSError

https://docs.python.org/3/library/exceptions.html#os-exceptions

OverflowError, ZeroDivisionError

RecursionError

ReferenceError

RuntimeError

StopIteration, StopAsyncIteration

SyntaxError, IndentationError, TabError

UnicodeError, UnicodeEncodeError, UnicodeDecodeError, UnicodeTranslateError

with-as (Context Manager)

上下文管理协议:实现方法是为一个类定义__enter__和__exit__两个函数。

with open_resource(args) [as target(s)]:

do_something

with-as语句的执行过程是,首先执行__enter__函数,它的返回值会赋给as后面的变量。

然后开始执行with-block中的语句,在with-block执行完成或发生异常或退出,会执行__exit__函数(释放资源或处理可能产生的异常)。

支持上下文管理协议的类

class Resource():

def __enter__(self): # 实际分配资源的操作在该方法中,而不在__init__()中

print('===connect to resource===')

return self

def __exit__(self, exc_type, exc_val, exc_tb):

print('===close resource connection===')

return True

contextlib.contextmanager装饰器

使用该装饰器可将构造资源的函数转换为支持上下文管理协议。

import contextlib

@contextlib.contextmanager

def open_func(file_name):

# __enter__ method

file_handler = open(file_name, 'r')

try:

yield file_handler

# __exit__ method

except Exception as exc: # 如果不需处理异常则无需使用try-except语句

pass

finally:

file_handler.close()

Exit handlers

atexit模块用于注册程序==正常退出==前的清理函数。可以注册多个函数,函数执行顺序与注册顺序相反。

atexit.register(func, *args, **kwargs)

atexit.unregister(func)

如果子进程由os.fork()创建,则继承父进程的退出处理函数;如果子进程由multiprocessing模块创建,则不会继承退出处理函数。

When used with C-API subinterpreters, registered functions are local to the interpreter they were registered in.

函数

定义函数

def function_name(arg1: int, arg2: float) -> float

"documentation"

statements

[return expr1, expr2, ...]

函数内部可访问全局脚本语句定义的变量。可以为输入输出参数添加类型提示。

参数

参数传递:不可变类型(数值、字符串、元组等)是值传递,可变类型(列表、字典、集合等)是引用传递;

关键字参数:使得调用函数时传入参数顺序可以与定义时不同,也可以为参数设置默认值(默认值在模块初始化时构造);关键字参数必须置于所有位置参数之后。

def func(arg1, age=50, name="miki")

不定长参数

*args用于传递任意数量的位置参数(列表或元组),**kwargs用于传递任意数量的关键字参数(字典)。

def functionname(formal_args, *args,**kwargs)

在函数调用时,也可以使用

*args将参数列表传递到函数中(需要与函数声明的参数个数或*args声明匹配),使用**kwargs将字典传入函数作为关键字参数(将值赋给与键名相同的参数,或与**kwargs声明匹配)。

返回值

通过return语句可以设置一个或多个返回值,或不返回值。

return不用于脚本退出,使用sys.exit()退出。

当返回多个值时,如果仅提供一个输出参数,则将返回值构造成元组。若提供多个参数存储返回值,则将从元组中一次读取元素给输出参数。

a, b, c = function_name(...) # 等效于 (a,b,c) = func_name(...)

d = function_name(...) # d = (a,b,c)

匿名函数 (Lambda表达式)

将函数作为对象保存和引用,也可以在使用函数的地方直接定义(而非使用def定义普通函数)。

add = lambda x, y : x+y

f = lambda x: 1 if x > 0 else -1

the_sum = add(1,2)

变量

Python的主要内置类型有数值、序列(string、list和tuple)、映射、类、实例和异常,方法也可以看作特殊的对象类型。每个变量(object)具有一个标识、类型和值。

创建和删除变量

定义变量不需要声明类型,根据赋值的类型确定变量类型。

a = b = c = 1

a, b, c = 1, 2, "john"

变量可重复赋值,赋值前后类型不需要一致(由赋值类型决定)。

删除变量:

del var_a, var_b

del list[i], dict[name]

变量作用域

在文件范围中定义的变量具有文件作用域,在文件其后的任意位置(包括调用的函数内部)都能访问。各文件中定义的变量属于不同的命名空间(模块名),互不影响。要引用其他模块中定义的全局变量,可使用import语句引入其他模块通过模块名访问或直接将该变量引入当前文件的命名空间。

import module

print(module.global_var)

from module import global_var

在文件中定义的函数引用全局变量时,总是引用该文件作用域中的全局变量,而不会使用调用该函数的文件中的全局变量。

可见性

当函数内部定义了与全局变量同名的局部变量,则全局变量将被隐藏(即使在定义局部变量之前也不能引用该同名全局变量)。使用global用于在函数内部对全部变量的声明和修改。

a = 'initialized'

def func()

global a

a = 'modified'

获取作用域中的变量信息:

dict_vars = locals() # 获取当前的局部作用域中的变量

dict_vars = globals() # 获取全局作用域中的变量

包括变量、函数、模块等信息。

在流程控制语句块中定义的变量在离开语句块后仍有效。

类型信息判断

type()返回变量的==类型信息可以和类型对象进行比较==。

type_info = type(var_name)

tf = type(x) == int # return True if x is int.

get_type_hints()可以查看模块、类、方法或函数的类型信息。

from typing import get_type_hints

Vector = list[float] # type alias

from typing import NewType

UserId = NewType('UserId', int) # New simple type

isinstance判断实例是否为某个类型(父类)的实例:

isinstance(obj, Type)

isinstance(obj, (Type1, Type2, ...)) # 任意一种类型

Type是在程序中使用的变量类型,不是字符串,例如pd.DataFrame,np.ndarray。

issubclass判断一种类型是否为某类型的子类:

isdubclass(subType, Type)

类型提示

age: int = 1 # 可不提供初始化值

容器类型需要使用专门定义的类型修饰变量。

from typing import List, Set, Dict, Tuple, Optional, Callable

x: Set[int] = {6, 7}

x: Dict[str, float] = {'field': 2.0}

x: Tuple[int, str, float] = (3, "yes", 7.5) # fixed size tuple

x: Tuple[int, ...] = (1, 2, 3) # variable size tuple

x: Optional[str] = some_function() # values that could be None

x: Callable[[int, float], float] = f # function

类型别名:

vector = List[float]

迭代器提示。

参数提示仅作为编写程序的辅助工具,在程序运行时并不会做相应的类型检查。

联合类型

可以为参数指定类型,且可使用typing.Union指定多种类型;

from typing import Union

def function_name(arg1:Union[str,int])

常量类型

from typing import Final # [Python 3.8]

Type hints cheat sheet (Python 3)。

类

类的定义:由成员,方法,数据属性组成。

class ClassName:

'''documentation''' #类文档字符串

static_var: Type = value

var1: Type # Annotate a member does not make it static.

# 构造函数

def __init__(self, value1, value2, ...) -> None:

self.var1 = value1 # 成员变量

self.var2 = value2

...

# 析构函数

def __del__(self):

release_unmanaged_resources

# 成员方法

def method_name(self, arg1, arg2, ...):

self.xxx # 调用类的成员变量或方法

# statements...

@staticmethod # 静态方法

def method_name(...)

statements

@property # read only property

def prop(self):

return self.xxx

@x.setter

def x(self, value):

self.__x = value

@x.deleter

def x(self):

del self.__x

静态变量

静态成员变量仅能通过类名或静态方法访问。实例可以定义与静态成员同名的成员变量(通过实例引用将隐藏静态变量)。子类可以定义与父类同名的静态变量(隐藏),通过子类名或实例将只能访问子类的静态变量。

==对实例成员的类型注释由于没有初始化,因此不会被视为静态变量==。

静态变量初始化:可在类外部对静态变量进行初始化,从而基于父类的静态变量对子类静态变量进行初始化。在子类内部使用父类静态变量初始化子类静态变量无效(得到None)。

构造

浅拷贝:很多类型(例如list、dict)提供copy()方法,支持对象的浅拷贝。这意味着对象中的成员变量如果是引用类型,则两个对象共享该引用类型成员。

析构函数__del__ ,__del__在对象销毁的时候被调用,当对象不再被使用时,__del__方法运行。Python使用了引用计数这一简单技术来跟踪和回收垃圾。

obj = ClassName(args) # 创建对象

使用.运算符来访问对象的属性。

类的成员

类可以看作由元数据、用户定义数据和方法组成的字典,使用dir(x)(x.__dir__())返回类包含的属性和方法组成的字典。

类的方法与普通的函数只有一个特别的区别——它们必须有一个额外的第一个参数名称, 按照惯例它的名称是 self(self不是Python关键字,换成其他标识符仍然有效)。self代表的是类的实例,代表当前对象的地址,而self.__class__是类的类型信息。

Python成员不存在访问控制,仅通过标识符在语义上区分。

-

__<private_member>:标记为私有属性/方法,其中形如__INNER_MEMBER__的成员为类的元数据。 -

_<protected_member>:标记为保护属性/方法。 -

<public_member>:标记为公开属性/方法。

类的元数据

通过类或对象均可访问类的元数据(所有对象共享)。

__class__:类型元信息(即type类型对象,等效于type(obj));

__name__:类名(字符串,==不包含类所在的包名==)。

__bases__ : 类的所有父类元信息构成的元素(包含了一个由所有父类组成的元组) 。

__dict__:所有成员变量名与对应的值组成的字典,等效于vars(obj);

__doc__:类的文档字符串 。

__module__: 类定义所在的模块(类的全名是__main__.className,如果类位于一个导入模块mymod中,那么className.__module__等于 mymod)

实例的元数据

obj.__str__(),:类成员信息的字符串表示,自动转换为字符串类型时调用该方法;

obj.__repr__():返回构造该对象的语句,repr(obj)会调用对象的该方法。调用eval(repr(obj))可重新构造该对象。

描述符协议

在类里实现了 __get__() 、__set__()、__delete__()其中至少一个方法。

class Score:

def __init__(self, default=0):

self._score = default

def __set__(self, instance, value): # 设置属性的值,进行验证

if not isinstance(value, int):

raise TypeError('Score must be integer')

if not 0 <= value <= 100:

raise ValueError('Valid value must be in [0, 100]')

self._score = value

def __get__(self, instance, owner): # 属性不存在、不合法等都可以抛出对应的异常

return self._score

def __delete__(self): # 删除内容

del self._score

class Student:

def __init__(math_score):

self.math = Score(math_score)

pass

数据类

dataclass(Python 3.7+)专门用于定义和存储数据的类型(更加适合序列化),封装了数据的初始化方法和基本运算方法(避免频繁编写这些基础代码)。dataclass继承自object类型,因此,开发者仍可基于dataclass编写自定义方法1。

定义数据

基于类型提示语法自动生成对应成员的定义,而无需重复在初始化方法中声明和初始化成员。

from dataclasses import dataclass

@dataclass

class Persion:

first_name: str

last_name: str = "Wang" # 支持默认值, 但必须在所有非默认值参数后

age: int

job: str

full_name: str = field(init=False, repr=False) # *

dataclass会自动生成__init__()、__eq__()(自动对比对象的所有成员)和__expr__()方法。由于dataclass的构造方法是自动生成的,也因此无法向父类传递初始化参数,所以通常自定义dataclass类型不再继承其他类。

*:当该成员的初始化依赖于其他成员变量时,不在自动生成的构造函数中初始化,而是在__post_init__方法中定义初始化方法。这种方式避免使用属性,在每次调用时需要重复计算值。

非可变对象

声明@dataclass(frozen=True),对象初始化后无法被更改。

数据转换

可轻易转换为元组或字典。

from dataclass import astuple,asdict

person:Tuple = astuple(Person(...))

person:Dict = asdict(Persion(...))

比较接口

@dataclass(order=True)将自动生成__lt__、__le__、__gt__、__ge__方法,从而支持排序比较。默认将对类中所有字段以此进行比较,在类定义中添加特殊的sort_index字段,该字段引用其他成员变量的值以定义排序参考值。

@dataclass(order=True)

class Persion:

# ...

sort_index: int = field(init=False, repr=False)

def __post_init__(self):

self.sort_index = self.age

继承语法

class ClassName (ParentClass1[, ParentClass2, ...]): # 支持多重继承

'Optional class documentation string'

def __init__(self, args):

super().__init__(...) # <=> super(ClassName, self).__init__(args)

# ...

在继承中基类的构造(__init__()方法)不会被自动调用,它需要在其派生类的构造中手动。需要通过基类名调用__init_()并且传递self变量。

方法重写(override)

当方法被重写后,==通过对象调用方法时将调用子类的方法==(即使是在父类中)。要通过super()以显式调用父类方法。

super().method(args) # <=> super(ClassName, self).method(args)

同名函数或成员调用:使用super().member()调用MRO搜索顺序上第一个存在该成员的类。如果要显式调用某一父类的方法,则使用super(SuperClass, self).method(args)。

在基于

pdb的调试环境下,如果在调试窗口调用父类方法,使用super().method(args)会报错(程序中正常执行)。

运算符重载

MRO(Method Resolution Order)

父类的初始化顺序:根据继承关系“深度优先—从左至右”搜索父类,确定初始化顺序(调用classname.__mro__查看类的搜索顺序)。

- 深度优先,按继承关系依次调用父类构造函数;

- 从左至右,当深度搜索到达顶端后,==如果顶层父类包含

super().__init__()调用==,则将调用第二条继承关系上的类型,并执行深度优先初始化; - 如果两条继承路线存在公共父类,则在第一条继承路线搜索到公共父类前会跳转到第二条继承路线,由第二条继承路线搜索到公共父类;多条继承路线具有公共父类的情况同理。

- 如果搜索过程中,某父类不存在

super().__init__(),则从该父类的代码开始,并按调用栈反向执行初始化。==在构造过程中已经被前面构造函数初始化过的属性会被后调用的构造方法再次初始化==。

如果在MRO搜索顺序中某个直接或间接父类未调用

super().__init__(),则==MRO初始化过程中断==(该类及MRO搜索顺序的后续类的构造方法不会被调用)。

参数传递:

-

==初始化过程中的参数传递与初始化顺序一致,而非子类分别传递给其各个直接父类==。因此在声明父类时,一定要将能通过

super().__init__()传递参数的父类声明在前,否则其后的父类无法获取参数。 -

传递给父类参数通常使用

*args和**kwargs代替(除非子类需要对相关参数进行处理)。def __init__(self, a,b,*args,c=1,b='hello',**kwargs)位置参数的顺序保持子类参数在前,父类参数在后(从而可以使用

*args来统一接收父类参数)。

Python Multiple Inheritance - JournalDev

mixin

抽取单一功能,提供给多个类继承,可视为带实现的接口;mixin模式适用于多个类各自有继承主线,但又共享部分功能。这部分功能即可通过mixin类型实现。

mixin类型不定义新的成员变量,仅定义关于目标混入对象的计算方法(可使用期望继承的类所包含的成员)。

https://stackoverflow.com/q/533631/6571140。

迭代器

迭代器Iterator提供__next__()方法以遍历所有元素;使用yield关键字的方法也可以实现简单迭代器。

def g(n: int) -> Iterator[int]:

i = 0

while i < n:

yield i

i += 1

可迭代对象Iterable提供两个方法:__iter__()和next()。通过iter(Iterable)可获取访问可迭代对象的迭代器。for语句实际需要传递迭代器对象,通过语法糖简化了对可迭代对象的访问语法。

python - What exactly are iterator, iterable, and iteration? - Stack Overflow

内存占用

import sys

s = sys.getsizeof(var)

所有内置类型均以对象封装,因此返回的为对象占用的内存(仅计算对象本身占用的内存,而不包括对象引用的内存)。第三方类型类型返回结果不一定准确。

程序结构

程序入口

模块中非类、函数定义的代码部分将在引用时被执行。

通过以下方式为程序设置一个入口,从而屏蔽引用模块中的非定义代码:

if __name__ == '__main__':

main_procedure

else:

module_initialization

注意:上述代码并非常规的主函数(

main(args)),只是一个普通的条件语句。可以自定义一个常规的主函数在上述结构中进行调用。

def main(args=None):

if args is None:

args = sys.argv

# main code

return value

if __name__ == '__main__':

sys.exit(main(sys.argv[1:]))

命令行参数处理

sys.argv[0]表示程序名,其他元素为传入参数。

for argi in sys.argv:

print(argi)

getopt

getopt采用Linux Shell的参数声明规则设置参数。读取参数的方法:

与UNIX类系统不同,非选项参数后的所有参数都不会被视为选项解析。

from getopt import getopt, GetoptError

options, args = getopt(cmd_args, short_opts, long_opts=[])

short_opts:代表短选项(命令行以-开头)的字母列表,如果一个选项还对应一个值,那么字母后添加:;

long_opts:代表长选项(命令行以--开头)的字符串列表,长选项如果需要一个值,则参数需要附加=。

命令行中,长选项的值可作为一个当都参数,或使用

=附加在选项名后。

返回值:options为选项列表,包括选项名(包括前缀)和对应的值(没有值则为空字符串);args为非选项参数。

典型用法:

def usage():

# print usage of the program, including options.

def main(sys_args):

try:

optlist, args = getopt(sys_args, short_opts, long_opts=[])

except GetoptError as err:

print(err) # will print something like "option -a not recognized"

usage()

return(2)

for option, value in optlist:

if option == '--test' or option == '-t':

# do something

...

ArgumentParser

ArgumentParser替代了OptionParser(从Python 3.2)。

创建参数转换实例:

from argparse import ArgumentParser

parser = ArgumentParser(

prog=None, # program name (default: sys.argv[0])

description=None, # information before argument help

usage=None, # usage syntax (default: auto generate)

epilog=None, # information after argument help

parent=[parent_parsers] # 继承父解析器实例的解析方法

)

parent:指定继承的参数解析实例。

添加参数规则:

parser.add_argument(

names_or_flags, # 可变参数列表:'--test', '-t', 'argname'

required=False,

dest='optname', # attribute name in return options

action='store',

nargs=1, # number of option arguments

const=0, #

default=None, # default value if not specified from command line

type=str, # type of option arguments

help=None, # option's usage information

metavar='NAME' # 帮助信息中作为选项值的标识(默认为长选项名大写)

)

ArgumentParser对参数控制更加严格,如果出现未配置的参数将产生异常。==参数名如果没有前缀,则代表位置参数==;而OptionParser将位置参数存储到一个单独的返回参数中。

参数解析规则说明:

dest:解析参数列表后存储参数值的变量名(参看parse_args()方法);如果没有指定字段,则会根据选项名生成合法的字段名;

nargs=N:选项所需要的参数个数,消耗N个参数构成列表。当需要获取位置参数而非选项时,nargs='?'消耗一个位置参数,nargs='*'消耗所有位置参数构成列表,此时names_or_flags作为存储位置参数的变量名。

type:值的类型,包括:string(默认)、int、float;整数值可以和短选项名组成一个参数,例如-n42等价于-n 42;bool类型参数使用store_true, store_false;

action:检测到选项后的处理方式

store:(默认处理方式)储存值,值的类型通过type指定;store_true|store_false:储存bool值True/False,对应的选项不需要另外参数设置值;store_const:'store_const'和'append_const'与const关键字结合使用,用于为选项保存一个常量。

default:选项的默认值(选项未出现在命令行的情况下设置默认值)。选项如果不是

bool类型,在命令行使用选项时必须提供值;

help:选项的帮助信息。当解析参数时,遇到-h或--help(程序退出)或调用parser.print_help()时会自动输出所有帮助信息。

%default可用于在帮助信息中表示输出变量的默认值。ArgumentParser自带-h,--help选项,命令行提供该选项时将输出帮助信息。参数解析器默认会添加帮助选项(

-h,--help),如果要禁用,设置parser.add_help=False。

转换命令行参数(默认为sys.argv[1:],==注意传入给args不要展开==):

options = parser.parse_args(args=None, namespace=None)

未在命令行提供的选项也会出现在options中,其值为默认值。返回值为NameSpace类型。

click

如果命令行嵌套子命令,可使用click进行命令转发。

程序运行信息

from inspect import currentframe, getframeinfo

frameinfo = getframeinfo(currentframe())

frameinfo.filename # 当前运行代码所在文件

frameinfo.lineno # 当前运行代码所在行号

frameinfo.function # 当前运行代码所在函数

模块(Module)

模块是一个文件,其中包含类,函数等的定义。==模块相当于一个命名空间,其中的定义与其他模块隔离==。

导入模块

import mod # modulename <- sys.modules['mod']

import mod as alias # aliasname <- sys.modules['mod']

from mod import name # objname <- sys.modules['mod'].name

from module import (name1,name2,...,namen,)

from module import * # 导入所有内容

from mod import name as alias # aliasname <- sys.modules['mod'].name

import importlib

path = importlib.import_module("os.path") # => import os.path as path

file, pathname, desc = importlib.find_module('os') # 查找模块

不能直接导入模块中的内容并设置别名。

从模块所在目录导入其他模块:

from . import module_name

相对路径是根据导入声明的包名

package.subpackage.module确定的,因此不可使用相对导入声明路径范围外的模块。由于__main__模块不包含任何路径信息,因此无法使用相对导入。

5. The import system — Python 3.9.5 documentation

引用模块

当导入整个模块时,使用模块名称访问其中的内容(类、函数等);也可以直接导入模块中的特定内容。

{module|alias}.name # use module contents via module name/alias

name # use name/alias to refer an imported class,funcion,...

alias

重载模块

检查模块是否导入:sys.modules记录了运行环境已导入的模块,从而防止模块被重复导入。

tf = 'modulename' in sys.modules # dict

tf = 'importedname' in dir() # 当前可见名称

tf = 'importedname' in globals() # 全局变量

重新加载修改过的包到当前正在运行的程序:

import importlib

importlib.reload(module) # <class module> not str

查看模块的文档

help(len) # doc for built-in functions

import pandas as pd

help(pd) # module doc

help(pd.DataFrame) # class doc

help(pd.DataFrame.to_csv)# function doc

相互引用

注意引用对象顺序,避免先引用未初始化的对象。

# in module A

from module B import b

def a()

# in module B

from module A import a

包(Package)

Package是特殊的模块(包含__path__属性的模块),包含subpackage和module。

常规package通常是一个文件夹中的所有模块以及子文件夹(sub-package)组成。__init__.py文件用于标识目录是一个package。当包被导入时,会自动执行__init__.py文件

my_package/

├── __init__.py

├── subpackage1/

│ ├── __init__.py

│ ├── module_x.py

│ └── module_y.py

├── subpackage2/

│ ├── __init__.py

│ └── module_z.py

└── module_a.py

Namespace packages

A namespace package is a composite of various portions, where each portion contributes a subpackage to the parent package. Portions may reside in different locations on the file system.

导入包中的模块

导入包名(相对搜索路径的目录路径)后,通过包名访问其中的内容;或将包名作为前缀导入其中的模块。

import pkg

import pkg.mod # packagename <- sys.modules['pkg']

import pkg.mod as alias # aliasname <- sys.modules['pkg.mod']

from pkg import mod # modulename <- sys.modules['pkg.mod']

from pkg import mod as alias # aliasname <- sys.modules['pkg.mod']

导入包名的时候会执行包目录下的__init__.py加载包中的模块。没有在__init__.py中指定加载的模块需要手动加载(import pkg.mod)。

查找路径

sys.path 是一个保存了查找包的路径的列表。Python解释器会自动将==Python程序所在目录==加入路径,从而方便导入同一目录下的其他文件。

==不要在包内部编写测试脚本==,运行该测试脚本时会将该脚本所在路径加入查找路径,从而破坏其所在包的结构。

程序的工作目录(

path.abspath(os.curdir))与程序所在目录可能不同,且不会加入搜索路径。语法检查的查找路径:在进行语法检查时(例如在VS Code中使用

pylint检查器),检查器的会将当前工作目录加入搜索路径,因此跟程序运行时的情形不同。为了保证程序运行时的路径也在检查器中,可在项目配置文件(settings.json)中配置"python.analysis.extraPaths": ["E:/Workspace/python"]

可以添加自定义搜索路径以导入第三方包:

sys.path.insert(0, '/lib/path') # 添加至头部

sys.path.append('/lib/path') # 添加至尾部

查询包是否在本地可加载:

import importlib

spec = importlib.util.find_spec("dask.dataframe") # None if not find

相对导入

from . import module # 导入同一包内同一层级的子包(或模块)

from .. import module # 导入同一包内上一层级的子包(或模块)

from .package import module

from ..package import module

不要将子包所在路径加入搜索路径,否则不能识别完整包结构,导致相对导入失败。

Python Modules and Packages – An Introduction。

标准库和应用

日期和时间

CGI

密码学

消息摘要

Python内置hashlib(消息摘要算法),包括 FIPS 的 SHA1, SHA224, SHA256, SHA384, and SHA512 (定义于 FIPS 180-2) 算法,以及 RSA 的 MD5 算法( 定义于 Internet RFC 1321)。消息摘要算法的输入为字节序列

在

zlib模块中包括adler32 或 crc32 哈希函数。

import hashlib

m = hashlib.sha256(b'init_data')

# m.update(a); m.update(b) => m.update(a+b)

m.update(b"Nobody inspects") # 向该对象追加消息(字节序列)

m.update(b" the spammish repetition")

m.digest() # 或hexdigest()

为了防止黑客通过彩虹表根据哈希值反推原始口令,在计算哈希的时候,不能仅针对原始输入计算,需要增加一个salt来使得相同的输入也能得到不同的哈希,这样,大大增加了黑客破解的难度。

加密算法

cryptography包含加密、消息摘要以及密钥生成等方法。

The low-level cryptographic primitives are often dangerous and can be used incorrectly. They require making decisions and having an in-depth knowledge of the cryptographic concepts at work.

PyCryptodome (代替pycrypto):Python Cryptography Toolkit提供加密算法(AES, DES, RSA, ElGamal, ...),同时也提供安全哈希函数(SHA256,MD5等)。

from Crypto.Hash import SHA256

hash = SHA256.new() # update, digest, hexdigest

from Crypto.Cipher import AES

obj = AES.new('This is a key123', AES.MODE_CBC, 'This is an IV456')

message = "The answer is no"

ciphertext = obj.encrypt(message)

obj2 = AES.new('This is a key123', AES.MODE_CBC, 'This is an IV456')

obj2.decrypt(ciphertext)

from Crypto.PublicKey import RSA

from Crypto import Random

random_generator = Random.new().read

key = RSA.generate(1024, random_generator)

signature = key.sign(hash, '')

public_key=key.publickey()

public_key.verify(hash_ver,signature)

cryptography vs PyCrypto | LibHunt

HMAC

hmac — Keyed-Hashing for Message Authentication — Python 3.10.7 documentation

RFC 2104 - HMAC: Keyed-Hashing for Message Authentication (ietf.org):通信双方使用共享密钥对消息的摘要(如MD5、SHA-1等)进行完整性进行校验。

import hmac

h = hmac.new(key, message, digestmod='MD5')

常见问题

-

ModuleNotFoundError: No module named 'win32api'

安装

pypiwin32包。

参考文献

Python开发环境配置

Python环境

系统集成Python环境

以Ubuntu为例,系统自带Python 3,用于支持相关系统组件工作。如果某些软件的运行需要依赖Python软件包而系统并未预装,则可以使用软件源管理工具(apt)安装。

使用相关python命令时需要注意:系统自带的

python3/pip3并没有创建符号链接python/pip,以便可以同时安装Python 2。

sudo apt install {python-package_name|python3-package_name}

sudo apt install python-is-python3 # 设置默认版本为Python3

如果软件源中找不到所需软件包,则可以通过pip工具从Python的软件仓库中下载软件包。系统的Python发行版默认未安装安装pip,需手动安装:

sudo apt install {python-pip|python3-pip} # Python package installer

python3-dev:Python软件开发依赖环境(header files and a static library for Python (default).),在Fedora/CentOS中命名为python3-devel。

查找软件包

pip list # list installed packages

pip show <package> # show information about installed packages

使用pip(pip3)安装和移除软件包:

pip install <pkgs> \

--user # 仅为当前用户安装,默认为系统范围安装

-r requirements.txt \ # 指定安装包声明文件

-i https://pypi.doubanio.com/simple/ \ # 强制使用镜像站点

--trusted-host 172.28.76.237 # 如果使用自建的代理站点,添加此选项

pip uninstall -r <requirements_file>

pip cache remove <pattern>|purge

使用

sudo在系统范围安装。Ubuntu等Linux发行版已经内置许多python模块,应该优先使用软件源管理工具而非

pip进行系统范围的Python软件包更新,否则可能导致系统功能出错。仅使用pip更新手动安装的软件包。如果不小心使用pip更新了pip,可以卸载更新后的版本并使用软件源管理工具重装。sudo python3 -m pip uninstall pip sudo apt install python3-pip --reinstall如果需要创建开发环境,使用虚拟Python环境(Virtualenv)

软件更新

pip list --outdated

pip install --upgrade package_name # 安装并更新依赖包(默认不更新)

pip-review # pip install pip-review

# pip install pipupgrade

使用较近的PyPi镜像站点可以加速软件包下载。

离线安装

下载(不安装)安装包,默认同时下载依赖包。

pip download [--python-version 3.7.4] package_name[==version]

-d,--dest <dir>: 下载目标文件夹(默认为当前工作目录)。指定

--python-version时,必须同时指定--no-deps或--only-binary=:all:。

安装离线包

pip install --no-index --find-links=/local_path package_name

--find-links:如果指定本地路径或file://url,则优先在本地目录中寻找安装文件。

--no-index:不使用在线仓库搜索依赖包;

Anaconda/Miniconda

Anaconda发行版打包了Python常用的软件包,可以从官网或镜像站点下载安装包。Miniconda是精简发行版,仅包含python语言环境和conda工具,其他软件包均需要在线下载。

Anaconda/Miniconda可以配置自定义的python环境屏蔽系统的Python,可以任意修改该环境而不会对系统产生影响。

在

Linux aarch64平台上,官方提供的安装包可能安装失败,可尝试使用conda-forge/miniforge: A conda-forge distribution. (github.com)。

version 'GLIBC_2.25' not found

Anaconda基础环境的Python版本参考发行注记:https://docs.anaconda.com/anaconda/reference/release-notes/。

安装conda运行环境

bash conda_installer.sh -b -f -p $INSTALL_PATH # 静默安装并指定安装路径

# -u更新已有安装;

静默安装模式不会执行初始化修改路径配置。如果安装期间未执行初始化,则Shell无法直接运行conda(不在路径中)。

eval "$($CONDAROOT/bin/conda shell.bash hook)" # 激活默认环境

conda init # [yes]

重新安装Anaconda/Miniconda

如果基础环境因为更新问题损坏(网络、杀毒软件拦截)需要重装,而不希望重装已配置的虚拟环境,可以将虚拟环境目录envs备份,在重装基础环境后还原。

卸载Anaconda/Miniconda

conda install anaconda-clean

anaconda-clean --yes # backup all files/directories in ~/.anaconda_backup

rm -rf $CONDA_HOME

最后清理~/.bashrc中的conda初始化代码。

conda配置

使用命令行修改配置项,

conda config --{system|env} SUB_COMMAND

conda配置文件包括三类:

--system:修改系统配置位于$CONDA_HOME/.condarc;--env:修改当前激活环境的配置,位于$CONDA_HOME/envs/$ENV/.condarc;- 如果未指定上述选项,则修改当前用户的配置,位于

$HOME/.condarc。

修改配置:

conda config --append KEY VALUE # 为配置项KEY追加一个值

--prepend/add KEY VALUE # 为配置项KEY前端插入一个值

--remove KEY VALUE # 从配置项KEY的值列表中删除匹配的VALUE

--set KEY VALUE # 更新配置项的值

--remove-key KEY # 移除配置项

列出当前的conda配置

conda config --show [CONFIG]

conda config --describe [CONFIG] # 显示配置项的说明

自动激活基础conda环境

是否在shell启动时启动Conda环境:

conda config --set auto_activate_base false # => auto_activate_base: false

使用conda进行包管理

conda info # infomation of conda installation (.condarc)

conda list [package_name] [-n envname]

conda search name --info

conda {update|upgrade} {--all | package_names}

conda [<cmd>] --help

Anaconda/Miniconda使用conda作为软件包管理工具。更新conda工具:

conda update -n base -c defaults conda

Anaconda发布的Python版本中,机器学习库

sklearn打包在scikit-learn中。

固定包的版本:在conda-meta目录中创建一个名为pinned的文件并加入不希望更新的包名以及版本信息(可以使用#注释行)。

numpy 1.7.* # stay on the 1.7 series

scipy==0.14.2 # fix to 0.14.2

conda update numpy --no-pin # 忽略pinned文件中的声明

每次执行更新时,conda会检查

pinned文件,因此使用--no-pin升级的包会恢复到pinned文件中声明的版本。

清理缓存

当软件包升级后,旧版本的软件包可能不再有用,因此可以从本地缓存删除。

conda clean \ # Remove unused packages and caches.

--all \ # index cache, lock files, unused packages and tarballs

-i,--index-cache \ # 清除索引缓存,保证用的是镜像站提供的索引。

-p,--packages \ # Remove unused packages

-t,--tarballs \ # remove cached package tarballs

-l,--logfiles

-d,--dry-run

安装软件包

conda {remove|uninstall} package_names

conda install -c conda-forge vaex=4.0.0 # --dry-run

conda install package_names \

--file requirements.txt \ # 安装文件给定的包

--freeze-installed \ # 避免已安装包升级

-n| --name ENVNAME \ # 目标环境名(未指定则为当前环境,默认为base)

-p,--prefix ENVPATH \ # 目标环境的目录

conda尝试安装最新的包,为此将升级其依赖的安装包。使用--freeze-installed避免已安装包自动升级。

指定仓库名:-c,--channel指定安装软件包优先使用的仓库;如果未指定该参数或指定仓库不包含相应的软件包,conda会检查.condarc中设定的channels中包含的其他仓库。

软件包声明文件格式:

channel::package_name=version=build_string # 使用指定使用*进行模糊匹配

声明

channel代替当前的默认通道;

常用声明格式:

pytorch # 安装最新的兼容版本

cudatoolkit>=11.3 # 限制最低版本 (命令行使用时需要使用""对><转义,避免解释为重定向)

cudatoolkit=11.3.* # 仅接受小版本更新(如果后续无build声明可省略.*)

cudatoolkit=11.3.1 # 安装固定版本

安装离线包

conda install --use-local /path/XXX.tar.bz

在Anaconda/Miniconda的Python环境中也可以使用pip进行软件包管理。

使用conda下载离线包:conda只能将软件包加载到本地仓库(缓存)中,而无法下载到指定文件夹。

conda本地仓库中的包无法用于pip安装。

安装Conda软件源中没有的包

pip install --upgrade-strategy "only-if-needed" packname

- 在使用conda安装尽可能多的包后,再使用

pip安装额外包;- 在单独虚拟环境中使用

pip(避免使用root环境);使用pip后,Conda无法识别相应的更改;- 如果后续还需要使用Conda进行更新或安装而外包,则使用基本环境再重新创建一个环境后再使用

pip;- 使用

-r, --requirements指定需要使用pip安装的包。

https://www.anaconda.com/using-pip-in-a-conda-environment/

虚拟Python环境

virtualenv

在指定目录ENV_DIR创建一个虚拟Python环境。

python3 -m venv ENV_DIR

创建虚拟环境,默认包含Python解释器(与系统中Python解释版本相同)、标准库等。可以使用

pip为虚拟环境安装额外的内容。在Debian/Ubuntu系统中需要首先安装

apt-get install python3-venv

Windows激活虚拟环境:

.\myenv\Scripts\activate.bat # windows cmd

.\myenv\Scripts\Activate.ps1 # windows powershell

Linux激活虚拟环境:

source myenv/bin/activate # on linux

which python # 查看python路径

pipenv

Pipenv: A Guide to the New Python Packaging Tool – Real Python

consolidate the pip & virtualenv into a single interface.

Conda虚拟环境

It makes your project more self-contained as everything, including the required software, is contained in a single project directory.

基于conda创建的虚拟环境并安装指定的软件包(和安装一样使用--file requirements.txt指定安装包)。Conda默认将虚拟环境置于envs目录下,并通过--names/-n选项指定要使用的环境名。使用--prefix可将虚拟环境置于任何路径下,但访问时也需要通过--prefix选项指定目录。

conda create -n pydev37 python=3.7 <pkgname=ver,...> \ # python=3*

--prefix ./envs ... # 指定虚拟环境的安装目录

conda create --name myclone --clone myenv # 复制已有环境

conda env remove --name myenv # <=> conda remove -n env_name --all

conda env list # <=> conda info --envs

*:如果创建环境时未指定Python版本,可能导致依赖解析很慢。支持创建Python 2.x环境。

虚拟环境中不会维护独立的软件包,而是由Conda维护一个统一的包目录(

pkgs)。通过conda-meta目录中的信息,可以定位到其引用的包路径,包的档案文件路径以及软件源路径。复制环境可直接将虚拟环境目录复制到

envs目录下(如果虚拟环境路径发生变化,需要使用conda-pack进行打包并在目标系统中解压并修复路径)

虚拟环境配置默认继承系统和用户配置,可以为虚拟环境添加设置覆盖默认配置。

查看conda环境更改历史:

conda list --revision[s]

conda install --revision=REVNUM # 恢复历史版本

虚拟环境信息文件:

conda env export [--from-history] > environment.yml

更新环境

conda env update --prefix | --name --file environment.yml --prune

复制环境

conda env create -f environment.yml #从配置文件创建虚拟环境

#=========================================

conda list --explicit > spec-file.txt

conda create --name myenv --file spec-file.txt

conda install --name myenv --file spec-file.txt

使用conda虚拟环境

conda activate env_name

conda deactivate

conda config --set env_prompt '({name})'

在脚本中尝试激活命令时会出现conda环境未初始化的错误,可在脚本中执行

source ~/.bashrc或将~/.bashrc中的conda初始化代码复制到用户脚本中。

Python - Activate conda env through shell script - Stack Overflow

Can't execute conda activate from bash script · Issue #7980 · conda/conda (github.com)

虚拟Python环境损坏

AttributeError: module 'brotli' has no attribute 'error'

解决方法:使用conda remove删除损坏的环境,并删除本地目录;

Pipeenv

虚拟环境打包部署

conda-pack可以将虚拟Python环境打包并部署到其他位置(操作系统相同)。可创建一个包含conda-pack的虚拟环境专门用于打包。

conda create -n pack -c conda-forge "conda-pack>=0.7" # pip install conda-pack=0.7

CondaPackError: Files managed by conda were found to have been deleted/overwritten...:

- Python升级到3.10后,其模块库目录下会创建一个

python3.1->python3.10的符号链接;这会导致旧版本的conda-pack无法正常工作,需要使用conda-pack>=0.7。- 如果虚拟环境中使用

pip安装了额外包,也可能导致上述错误。因此可将pip的安装包单独下载,再在目标环境中执行离线安装。

然后将目标环境打包环境为一个压缩档案文件(tar.gz):

conda-pack --name my_env \

--output out_name.tar.gz \ # 指定环境名

-d target_env_path \ #目标主机上虚拟环境的路径

--force

conda-pack -p /explicit/path/to/my_env # 指定环境路径

在目标位置解压文件,并激活虚拟环境(要求目标环境安装conda):

tar -xzf my_env.tar.gz -C conda_path/envs/my_env

source my_env/bin/activate # 激活环境 add `my_env/bin` to your path

conda-unpack # 修复库的路径(可在未激活环境情况下运行,指定路径)

conda-unpack是conda-pack打包到虚拟环境中的程序(envname/bin目录下),在解压后修复某些库的路径。==如果打包时指定-d选项,则不再打包unpack程序==。

Conda-Pack — conda-pack 0.6.0 documentation.

Arm64版本Python

支持aarch64 (arm64)的Conda环境:

- conda-forge/miniforge: A conda-forge distribution. (github.com)

- https://repo.anaconda.com/archive/Anaconda3-2021.04-Linux-aarch64.shell

需要使用conda-forge作为默认源(miniforge的默认设置),且不能使用国内镜像源(同步不完整)。

软件源配置

pip软件源

配置软件源和下载设置:

pip config set global.timeout 6000

pip config set global.index-url https://pypi.doubanio.com/simple/

pip config set install.use-mirrors true

pip config set install.mirrors https://pypi.doubanio.com/simple/

该配置文件位于$HOME/.pip/pip.conf(系统自带Python的配置文件位于$HOME/.config/pip/pip.conf)。也可以手动创建并编辑该文件(Windows下的配置文件位于%HOMEPATH%\AppData\Roming\pip\pip.ini),在文件中添加以下内容:

[global]

timeout = 6000

index-url = https://pypi.doubanio.com/simple

[install]

use-mirrors = true

mirrors = https://pypi.doubanio.com/simple

常用软件源包括:

https://pypi.doubanio.com:豆瓣;http://mirrors.aliyun.com/pypi:阿里;http://pypi.mirrors.ustc.edu.cn:中国科学技术大学;https://pypi.tuna.tsinghua.edu.cn:清华大学;

本地镜像可用Nexus配置。

conda软件源

添加默认仓库defaults的地址:

conda config --add default_channels \

https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main/ # add default channel URL

conda config --set show_channel_urls yes # 显示下载内容的URL

添加自定义仓库名称和地址:

conda config --{prepend|append} channels <new_channel>

conda config --set custom_channels.conda-forge \

https://mirror.sjtu.edu.cn/anaconda/cloud/

直接编辑该文件:

channels:

- conda-forge

- defaults

default_channels:

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/r

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/msys2

custom_channels:

conda-forge: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

pytorch: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

配置文件中channels可包含多个源,优先级从上到下递减。默认从高优先级的源选择同名软件包(channel_priority=strict);反之优先选择高版本号的同名软件包。

conda config --set channel_priority strict

通过default_channels配置defaults仓库的实际地址;通过custom_channels配置其他仓库对应的地址;如果未设定相应的地址信息,则默认连接到Anaconda官方仓库。

列出当前的仓库配置

conda config --show channels

conda config --show-sources # show all sources

conda config --validate # 验证仓库源

仓库镜像

https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/:清华大学,包含pytorch、conda-forge等多个仓库,其中conda-forge包含linux-aarch64架构的仓库,可用于ARM平台;https://mirrors.bfsu.edu.cn/anaconda/cloud/:北京外国语大学(与清华大学镜像源一致);https://mirror.sjtu.edu.cn/anaconda/cloud/:上海交通大学(不包含conda-forge/linux-aarch64);https://mirrors.aliyun.com/anaconda/cloud/:阿里云(不包含conda-forge/linux-aarch64)。

使用Nexus可创建镜像代理

Nexus Conda代理不会获取

current_repodata.json,因此使用conda时总是会回退使用repodata.json,导致解析速度变慢(直接使用镜像源则不会有此问题)。mamba总是使用repodata.json不会受此影响。

多数镜像源仅包含最常用的仓库,如conda-forge、pytorch,而一些开源库在Anaconda官方仓库维护了独立的仓库(仅包含开源库相关包),因此要使用这些仓库需要使用Anaconda官方仓库作为代理源。

Name=anaconda-cloud

Remote=https://conda.anaconda.org/

URL=http://192.168.178.52:8081/repository/anaconda-cloud

软件包下载优化

安装mamba/libmamba加速依赖解析和下载

mambais a reimplementation of the conda package manager in C++.

mamba支持多线程并行下载仓库数据和包文件,使用libsolv以加速依赖解析(用于RPM包管理器)。

conda install -n base -c conda-forge mamba

安装完成后,使用mamba代替conda进行包管理,其语法与conda一致。

最新的

conda版本(22.9+)提供--experimental-solver libmamba选项(需要安装conda-libmamba-solver包),使用mamba进行依赖解析,但仍采用conda下载包。

mamba/libmamba虽然加速解析和下载,但不使用本地缓存导致重复下载(虽然检测到本地缓存包但似乎URL不匹配)。如果是通过本地镜像仓库下载,则重复下载没有多大影响;防止,如果通过远程仓库下载,这重复下载比较浪费时间。

配置HTTP代理

conda会自动检测系统代理配置,但不支持$no_proxy例外项。如果conda使用的代理配置与系统配置不同,可在.condarc中指定(同样不支持例外项)。

proxy_servers:

http: http://172.28.76.4:3128

https: http://172.28.76.4:3128

conda/mamba使用urllib3,会读取环境变量$http[s]_proxy;Windows中优先检测环境变量$env:HTTP[s]_PROXY,其次检测网络设置中的代理设置,可通过代理设置的例外项排除不需要通过代理访问的镜像源地址,例如本地仓库代理。)

网络超时设置

当使用nexus镜像代理时,新内容会首先下载到代理服务器,然后再下载到本地。因此,代理服务器如果下载速度较慢会导致本地conda下载超时。这种情况,可将网络读取的超时限制调大。

remote_read_timeout_secs: 180.0 # 60.0 by default

mamba忽略该选项,尝试设置export MAMBA_NO_LOW_SPEED_LIMIT=1。

开发环境

标准库

-

系统管理:

os, sys, shutil -

日期时间:

datetime, time, calendar -

高级数据结构:

collections, array, enum -

输入输出控制:

io, fcntl, logging, getpass, warnings -

数据处理:

re,struct -

文件解析:

csv, configparser, json, xml, htmlPython有三种方法解析XML,SAX,DOM,以及ElementTree。ElementTree就像一个轻量级的DOM,具有方便友好的API。代码可用性好,速度快,消耗内存少。

**注:**因DOM需要将XML数据映射到内存中的树,一是比较慢,二是比较耗内存,而SAX流式读取XML文件,比较快,占用内存少,但需要用户实现回调函数(handler)。

-

数据持久化:

pickle, marshal, sqlite3sqlite使用文件保存数据,因此无需运行任何服务。Python内置sqlite3提供sqlite数据库的操作。 -

数据库:

mysql-connector-python,psycopg2(PostgreSQL)DB-API 是一个规范. 它定义了一系列必须的对象和数据库存取方式, 以便为各种各样的底层数据库系统和多种多样的数据库接口程序提供一致的访问接口 。

-

网络通信:

socket,ipaddress,xmlrpc,email,smtpd,smtplib,imaplib,poplib,cgi,ftplib,uuid,base64,urllib.parse -

HTTP:

http,urllib.requesturllib是一个内置在Python标准库中的模块,并使用

http.client来实现HTTP和HTTPS协议的客户端。 -

密码学:

hashlib, hmac -

数据压缩归档:

zlib,gzip,bz2,lzma,zipfile,tarfile; -

任务调度:

asyncio, multiprocessing, threading, concurrent, signal, subprocess, queue, select, atexit:concurrent.futures -

程序管理:

importlib, inspect, typing, argparse, getopt, traceback; -

调试:

timeit, trace;

第三方库

-

语法格式:

autopep8,pylint; -

系统管理:

filelock, psutil -

数值计算:

numpy、scipy; -

数据可视化:

matplotlib, seaborn, bokeh, plotly, pyecharts; -

Web开发:

django, flask, tornado, requests, beatifulsoup, scrapy;urllib3,requests -

图形界面开发:

wxPython, PyQT, TKinter; -

命令行工具:

click、rich`。 -

机器学习。

数据处理

pandas、pandasql、pyarrow、dask;

使用conda安装时pyarrow,默认的仓库安装版本较旧(0.15),导致兼容问题,因此使用conda-forge通道。

conda install -c conda-forge pyarrow

conda install dask

pip install "dask[complete]" # Install everything

Pandas:

pd.show_versions() # 查看系统环境、pandas版本及其依赖包的版本

pd.io.parquet.get_engine('auto') # 获取parquet读写引擎

引入

pandas包后立即调用该方法,解决与matlab.engine的环境冲突。

Visual Studio

安装Python工作负载;

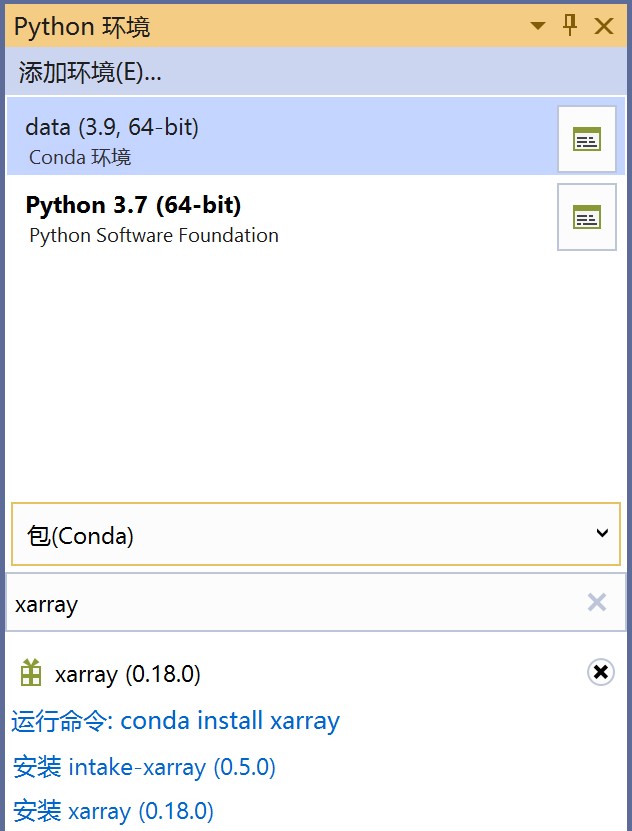

安装Python/Conda虚拟环境;

通过Python环境窗口,安装或卸载包或启动交互式Python命令环境;

Visual Studio Code(Python Extension Pack)

Conda环境未正确加载会导致某些包(例如numpy)无法被导入。解决方案:

-

为保证终端中Conda环境自动加载(终端启动时加载),执行

conda init cmd.exe|powershell # conda config --set auto_activate_base false初始化文件在

%USER%/Documents/WindowsPowerShell/profile.ps1。 -

在VS Code中配置Conda路径,从而使终端启动时自动激活Conda虚拟环境(

cmd)。"python.condaPath": "C:\\tools\\miniconda3\\Scripts\\conda.exe"

To ensure the environment is set up well from a shell perspective, one option is to use an Anaconda prompt with the activated environment to launch VS Code ==using the

code .command==. At that point you just need to select the interpreter using the Command Palette or by clicking on the status bar.Conda environments can't be automatically activated in the VS Code Integrated Terminal if the default shell is set to PowerShell.

忽略单行警告,在行末添加声明。如果要忽略同一文件,则将声明置于单独行。

import config.logging_settings # type: ignore => pylance

import config.logging_settings # pylint: disable=unused-import

pylint可以放在type标记后。

全局忽略警告:

"python.linting.pylintArgs": [

"--disable=unused-import",

"--disable=too-few-public-methods"

] // => pylint

"python.analysis.diagnosticSeverityOverrides": {

"reportUnusedImport": "information",

"reportMissingImports": "none"

} // ==> pylance

Pylance和pylint可同时启用,因此需要设置两项配置。

Better Comments插件:有5中类型的注释高亮,分别用符号* ? ! //todo来区分。

自动补全和语法分析配置

{

"python.autoComplete.extraPaths": [

"/home/gary/dataproc/dataproc/lib"

],

"python.analysis.extraPaths": [

"/home/gary/dataproc/dataproc/lib"

]

}

单元测试

可将项目目录下的一个文件夹设置为单元测试目录(如test);单元测试脚本需要位于该目录下,以test_*.py模式保存的文件将被自动发现为测试脚本1。单元测试环境会自动将测试目录和当前项目目录加入PYTHONPATH。

Tip: Sometimes tests placed in subfolders aren't discovered because such test files cannot be imported. To make them importable, create an empty file named

__init__.pyin that folder. (为每一级测试目录创建__init__.py测试路径可被识别为包)由于测试目录位于搜索路径的最前,因此应该避免测试目录中包含与系统模块或用户模块同名的文件或文件夹(导致其屏蔽系统/用户模块的导入)。

单元测试项自动发现

如果单元测试脚本中包含错误(无法捕获异常),则在发现阶段会将其分类的错误测试项一栏(完整错误日志可在Python输出窗口中查看);解决错误后会自动更新到对应的测试目录树下。

在VS Code中使用Jupyter Notebook

需要安装ipykernel以启动内核。

Jupyter

安装

conda create -n jupyterlab -c conda-forge {jupyterlab|jupyterhub}

conda install -c conda-forge ipywidgets jupyterhub-idle-culler

JupyterLab

路径信息

jupyter --path配置文件、数据等的默认路径(以下给出首选路径)。

config:

$HOME/.jupyter

data:

$HOME/.local/share/jupyter

runtime:

$HOME/.local/share/jupyter/runtime

生成配置文件:配置文件中包含默认值(可进行修改)

jupyter lab --generate-config # -> $HOME/.jupyter/jupyter_lab_config.py

网络配置

c.ServerApp.base_url='/analyze/jupyter'

c.ServerApp.ip = 'localhost' # --ip=0.0.0.0

c.ServerApp.port = 0 # --port=8888

如果使用代理出现403错误,尝试设置

c.ServerApp.disable_check_xsrf=True禁用cross-site-request-forgery检查。

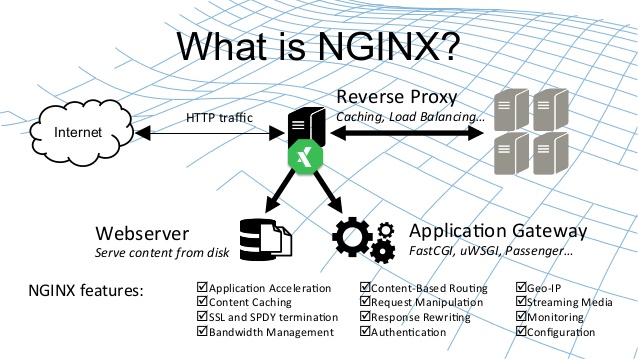

NGINX反向代理JupyterLab服务,参考JupyterHub反向代理配置。

运行环境配置

c.ServerApp.root_dir='~/jupyter'

c.ServerApp.allow_root = False # --allow-root: Allow the server to be run from root.

c.ServerApp.autoreload = True # --autoreload

c.ServerApp.open_browser = False # --no-browser

安全配置

c.ServerApp.allow_origin = '*'

c.ServerApp.certfile = ''

c.ServerApp.keyfile = ''

c.ServerApp.cookie_secret = b''

c.ServerApp.cookie_secret_file = ''

c.ServerApp.password = '' # from jupyter_server.auth import passwd; passwd()

启动JupyterLab服务

以系统服务启动:

[Service]

Type=simple

Environment="WORKDIR=/home/ml/jupyterlab"

Environment="LOGDIR=/var/log/jupyterlab"

ExecStartPre=/usr/bin/mkdir -p /tmp/jupyter $WORKDIR

ExecStart=/usr/local/miniconda3/envs/jupyter/bin/jupyter lab $OPTIONS \

> ${LOGIDR}/server.log 2> ${LOGIDR}/server.error.log

TimeoutSec=10

ExecStop=/bin/kill -s TERM $MAINPID

User=ml

JupyterHub

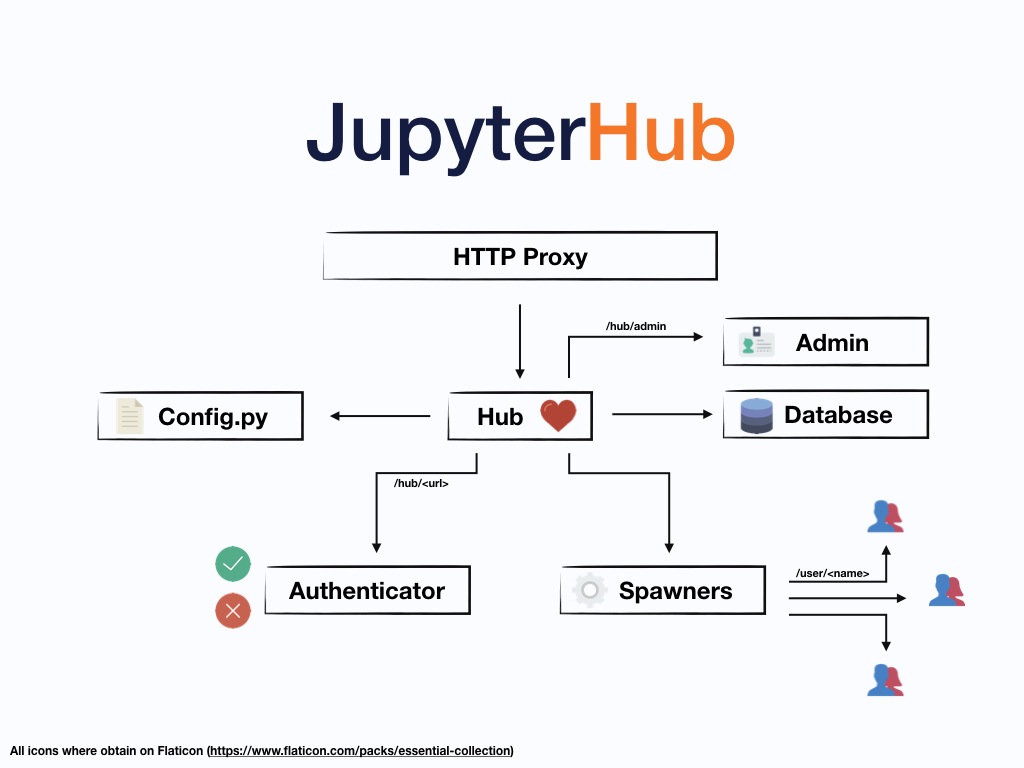

系统架构

Jupyter系统组件包括:

- HTTP Proxy:代理用户请求,对外的唯一的Web接口;

- Hub:

- Spawners:管理用户服务;

- Authenticator:用户鉴权组件。

各个服务通过HTTP进行通信,因此可以分离部署。

Connections to user servers go through the proxy, and not the hub itself. If the proxy stays running when the hub restarts (for maintenance, re-configuration, etc.), then user connections are not interrupted. For simplicity, by default the hub starts the proxy automatically, so if the hub restarts, the proxy restarts, and user connections are interrupted. It is easy to run the proxy separately, for information see the separate proxy page.

jupyterhub token|upgrade-db -h

配置JupyterHub

推荐以下安装配置:

/srv/jupyterhubfor all security and runtime files/etc/jupyterhubfor all configuration files/var/logfor log files

生成并修改配置文件(默认输出到当前目录,使用-f选项指定输出目录)。

jupyterhub --generate-config -f /etc/jupyterhub/jupyterhub_config.py

jupyterhub -h,--help-all # 列出所有命令行配置项

configurable-http-proxy -h # 代理配置项

除了上述命令列出的配置项外,所有配置项均可通过命令行选项进行配置以覆盖配置文件中的对应配置项。

--Class.trait='value' # c.Class.trait in [jupyterhub_config.py]

验证配置:

jupyterhub --show-config -f config_file # 列出当前生效的配置(仅非默认值项)

数据存储配置

c.JupyterHub.data_files_path = '/usr/local/share/jupyterhub'

c.JupyterHub.db_url = 'sqlite:////var/lib/jupyterhub/jupyterhub.sqlite'

在读取配置文件时:

sqlite:///视为相对路径,绝对路径需要使用sqlite:////。

JupyterHub网络配置

bind_url配置JupyterHub代理服务(用户的Web访问地址,代替弃用的ip、port和base_url)。省略IP则监听所有地址接收的请求,默认URL根路径为/。

c.JupyterHub.bind_url='http://:8000/' # --url

api_url配置REST API接口的访问地址(Hub服务通过该接口与代理服务通信)。

c.ConfigurableHTTPProxy.api_url = 'http://localhost:8001'

hub_bind_url配置Hub服务的访问地址(代理与Spawners通过该地址与Hub通信,代替hub_ip和hub_port)。hub_connect_url用于分离部署时指定Hub服务的地址(代替hub_connect_ip/hub_connect_port)。

c.JupyterHub.hub_bind_url = 'http://localhost:8081'

c.JupyterHub.hub_connect_url = 'http://hub_ip:8081'

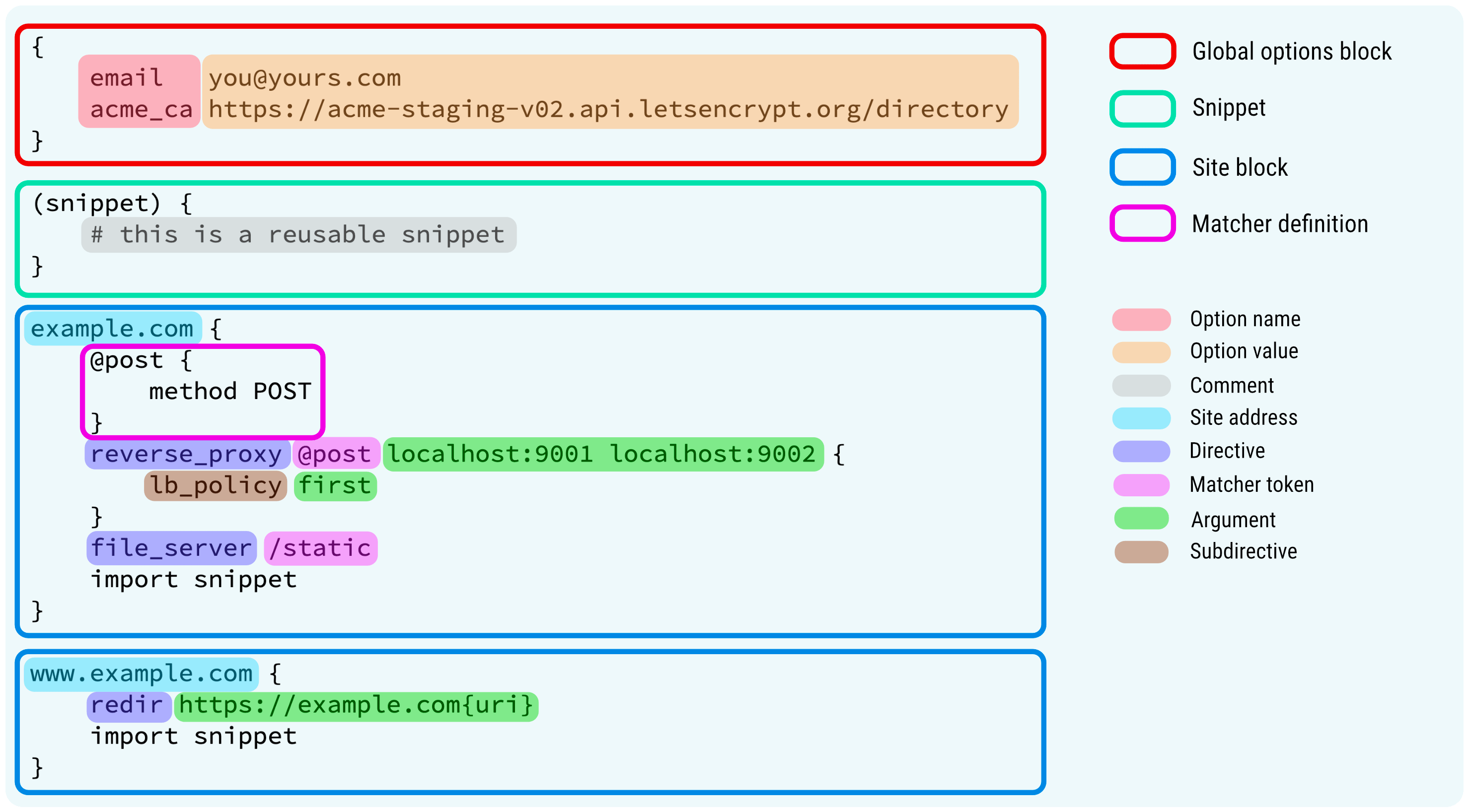

map $http_upgrade $connection_upgrade {

default upgrade;

'' close;

}

server {

location /jupyterhub {

proxy_pass http://127.0.0.1:8000;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header Host $host; # $http_host for http connection

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

# websocket headers

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection $connection_upgrade;

proxy_set_header X-Scheme $scheme;

proxy_buffering off;

}

}

Spawner网络配置:

c.Spawner.ip = '127.0.0.1'

c.Spawner.port = 0

使用SSL:

--ssl-key my_ssl.key # c.JupyterHub.ssl_key = '/path/to/my.key'

--ssl-cert my_ssl.cert # c.JupyterHub.ssl_cert = '/path/to/my.cert'

使用

jupyterhub --generate-certs生成自签名证书和私钥。

用户访问控制

配置JupyterHub用户

c.Authenticator.allowed_users = {'mal', 'zoe', 'inara', 'kaylee'} # 初始化用户集合

c.Authenticator.admin_users = {'mal', 'zoe'}

if

allowed_usersis not set, then all authenticated users will be allowed into your hub.

可选:使用系统用户进行鉴权:creating that user via the system adduser command line tool.

c.LocalAuthenticator.create_system_users = True

# PAMAuthenticator -> LocalAuthenticator -> Authenticator

This approach is not recommended when running JupyterHub in situations where JupyterHub users map directly onto the system’s UNIX users.

自动创建用户可能会失败(CentOS7),可提前创建系统用户并进行初始化。

allowed_users=(mal zoe inara)

for u in "${users[@]}"; do

useradd -m -g ml $u; # 添加用户并添加到预定义的组

if [ $? -eq 0 ]; then # 为新用户设置默认密码(用于JupyterHub初始登录验证,登陆后修改密码)

passwd $u --stdin <<< '1234abcd'

fi

cat /etc/passwd | grep --color=always $u # 显示用户基本信息

done

Hub和Proxy(ConfigurableHTTPProxy )之间通过一个secret token来验证请求。此令牌可通过openssl生成,保存在配置文件或环境变量中。如果未设置,则Hub会自动随机生成一个,那么重启Hub的同时需要重启Proxy。

c.ConfigurableHTTPProxy.api_token = 'abc123...def'

export CONFIGPROXY_AUTH_TOKEN=$(openssl rand -hex 32)

cookie secret用于对浏览器中用于鉴权的Cookies信息进行加密,可通过openssl生成。

openssl rand -hex 32 > /srv/jupyterhub/jupyterhub_cookie_secret

chmod 600 /srv/jupyterhub/jupyterhub_cookie_secret

export JPY_COOKIE_SECRET=$(openssl rand -hex 32)

有三种指定方式:配置为环境变量,在配置文件中指定该信息所在的文件或在配置文件中指定该信息。

c.JupyterHub.cookie_secret_file = '/srv/jupyterhub/jupyterhub_cookie_secret'

c.JupyterHub.cookie_secret = bytes.fromhex('64 CHAR HEX STRING')

如果未配置上述任何方法,则

jupyterhub_cookie_secret默认创建在运行JupyterHub的用户的主目录下。该文件应该仅有该用户的读写权限,否则服务不会启动。使用环境变量配置的随机生成密码会在重启服务时重新生成,导致所有登录会话失效。

基于角色的访问控制:Scopes are specific permissions used to evaluate API requests. Roles are collections of scopes that specify the level of what a client is allowed to do.

c.JupyterHub.load_roles = [

{

'name': 'server-rights',

'description': 'Allows parties to start and stop user servers',

'scopes': ['servers'],

'users': ['alice', 'bob'],

'services': ['idle-culler'],

'groups': ['admin-group'],

}

]

Use Cases — Scopes in JupyterHub

配置用户后台服务

c.Spawner.cmd = ['jupyterhub-singleuser'] # 后台启动命令

# c.Spawner.cmd=["jupyter-labhub"]

c.Spawner.notebook_dir = '~/notebooks' # 工作目录路径(默认为~)

Since the single-user server extends the notebook server application, it still loads configuration from the jupyter_notebook_config.py config file. Each user may have one of these files in $HOME/.jupyter/. Jupyter also supports loading system-wide config files from /etc/jupyter/, which is the place to put configuration that you want to affect all of your users.

修改用户的工作目录为Jupyter服务独占目录,防止与用户的其他服务的文件冲突。如果为用户配置了非默认工作目录,则需要在用户服务初始化前进行检查确认该目录存在。JupyterHub配置文件中提供了初始化过程的接口。

def my_hook(spawner):

import os,pwd,shutil

username = spawner.user.name

path = f'/home/{username}/notebooks'

if not os.path.exists(path):

os.makedirs(path, mode=0o755, exist_ok=True)

passwd = pwd.getpwnam(username)

os.chown(path, passwd.pw_uid, passwd.pw_gid)

src = '/usr/local/share/jupyterhub/.bashrc'

if os.path.exists(src):

dest = f'/home/{username}/.bashrc'

shutil.copy(src, dest)

os.chown(dest, passwd.pw_uid, passwd.pw_gid)

c.Spawner.pre_spawn_hook = my_hook

除了工作目录外,这里也附带配置了用户的Shell初始化文件(